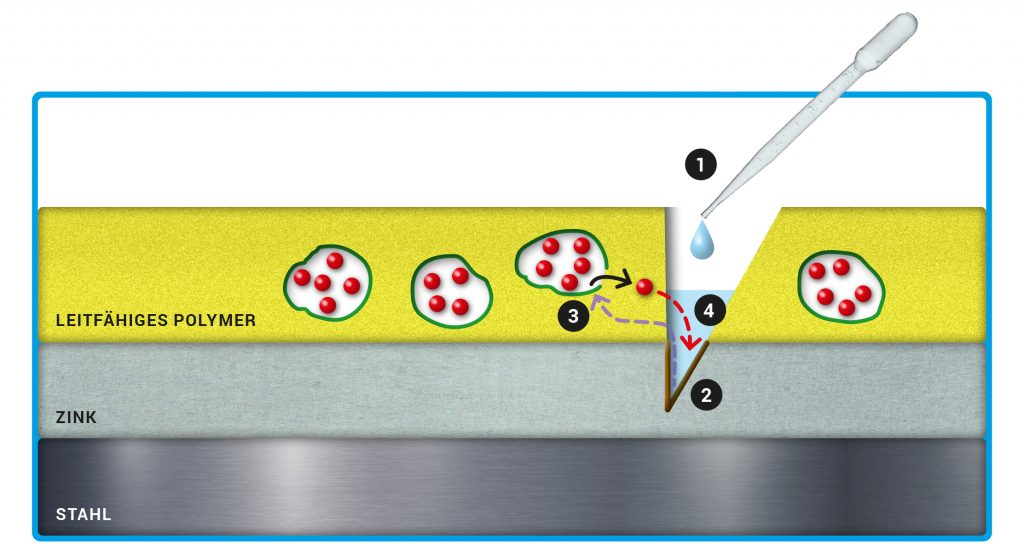

In der Schutzschicht aus leitfähigem Polypyrrol (gelb) stecken Kapseln, deren Wände (grün) aus leitfähigem Polyanilin bestehen. Die Kapsel enthalten die Inhibitor-Teilchen (rote Kugeln). In vielen Arbeiten wurde 3-Nitrosalicylat verwendet, das gut auf Zink wirkt. Unter der Polymerschicht liegt die Zinkschicht. Bei den Experimenten wird in die obere Beschichtung hineingeschnitten und etwas Salzlösung auf die offene Stelle getropft (1). So beginnt das Zink unter dem Schnitt zu korrodieren (2). Dadurch sinkt das Elektrodenpotenzial – das entscheidende Trigger-Signal, welches sich vom Defekt im Zink bis zur Polymerschicht und den darin eingebetteten Kapseln ausbreitet (3). Die Kapseln nehmen Kationen und Wassermoleküle auf, die Kapselwände werden porös und durchlässig. Die freigesetzten Inhibitor-Teilchen diffundieren anschließend zum Defekt (4).

© MPG // HNBM-design.de // CC BY-NC-SA 4.0

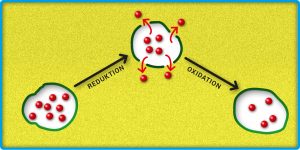

Die Kapselwände (grün) bestehen aus leitfähigem Polymer. Durch Reduktion werden diese porös und die Inhibitor-Teilchen (rote Kugeln) verlassen die Kapsel. Erfolgt eine Rückoxidation des Polymers, schließen sich die Poren in der Kapselwand wieder.

© MPG // HNBM-design.de // CC BY-NC-SA 4.0

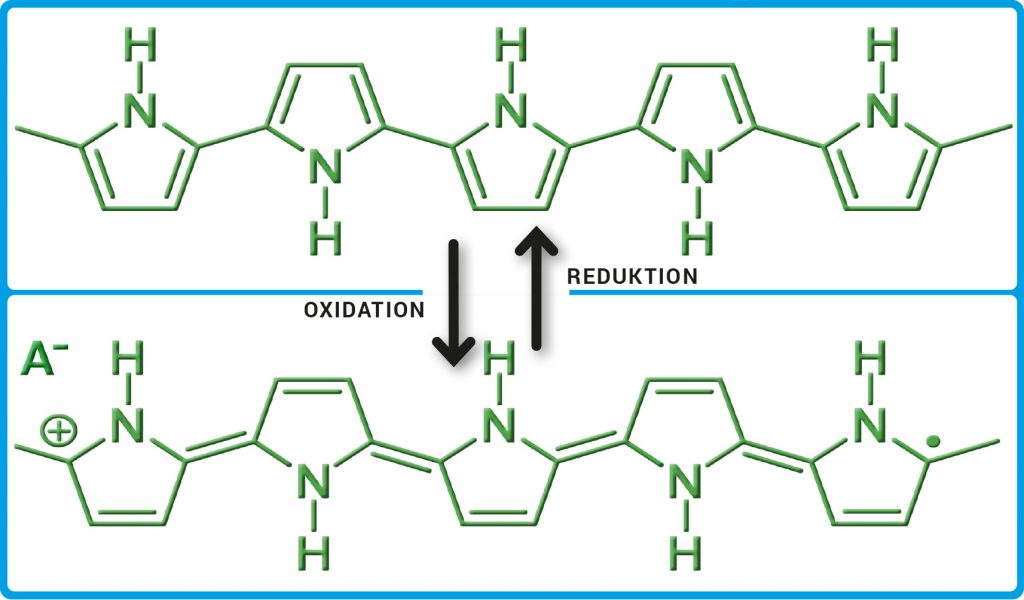

Die Abbildung zeigt Ausschnitte aus dem Polymer. Bei der Oxidation werden dem Polypyrrol Elektronen entzogen und positive Ladungen erzeugt. Für den notwendigen Ladungsausgleich sorgen eingelagerte Anionen (A–). Im halb-oxidierten Zustand (unten) ist das Polypyrrol leitend. In der reduzierten Form (oben) ist es nicht-leitend.

© MPG // HNBM-design.de // CC BY-NC-SA 4.0

© Stefan Alfonso / iStock

Genua, 14. August 2018: Kurz nach halb zwölf bricht die Morandi-Brücke zusammen. Autos und Lastwagen stürzen in die Tiefe, es gibt 43 Tote. Der Grund für das Unglück: Korrosion. Eine völlig durchgerostete Stahltrosse war gerissen. Gutachten gehen davon aus, dass die Brücke über Jahre mangelhaft gewartet worden war. Korrosion kann Menschenleben kosten. Und sie richtet auch enorme wirtschaftliche Schäden an – weltweit. Denn überall, nicht nur in Brücken, sondern auch in Gebäuden, Containern, Schiffen, Autos und Flugzeugen steckt Stahl. Beginnt er zu rosten, werden teure Reparaturen fällig. Korrosion verschlingt jährlich geschätzt 3 bis 4 Prozent des Bruttoinlandsprodukts von Industriestaaten.

Doch was passiert bei der Korrosion des Stahls? Dieser besteht vorwiegend aus Eisen, und als unedles Metall reagiert Eisen leicht mit Stoffen in der Umgebung. So oxidiert es mit Sauerstoff in Gegenwart von Wasser und es entsteht dabei Eisen(II)-hydroxid. In einer weiteren Reaktion oxidiert das Eisen(II)-hydroxid dann zu Eisen(III)-hydroxid: Der rotbraune Rost wird sichtbar. Nach und nach wird immer mehr Eisen in Eisen(III)-hydroxid umgewandelt. So frisst sich der Rost langsam durch das Metall hindurch. Die Korrosion hat ihr Zerstörungswerk begonnen.

Wie lässt sich Stahl vor seinem größten Feind schützen? Kunststoffbeschichtungen können zum Beispiel verhindern, dass das Eisen in Kontakt mit den Stoffen in seiner Umgebung kommt. Oder Zink liegt als Schutz vor Korrosion über dem Stahl. Als unedleres Metall oxidiert Zink zuerst und „opfert“ sich so für das Eisen, bis die Zinkschicht irgendwann aufgebraucht ist. Wissenschaftlerinnen und Wissenschaftler suchen nach neuen Wegen, Stahl vor Rost zu schützen. Zum Beispiel gibt es den amorphen Stahl, der wegen seiner Nanostruktur weniger korrosionsanfällig ist. Und es gibt den Ansatz, neuartige Beschichtungen zu entwickeln, die eine beginnende Korrosion an beschädigten Stellen stoppen und sich dann selbst reparieren. Solche intelligenten, selbstheilenden Schutzschichten müssen bestimmte Voraussetzungen erfüllen. Sie sollen Inhibitoren – Wirkstoffe, die die Korrosion stoppen – speichern und erst dann freisetzen, wenn die Beschichtung beschädigt ist und das darunter liegende Metall angegriffen wird. Dafür braucht es ein zuverlässiges Trigger-Signal sowie einen Mechanismus, der den Transport der Wirkstoffe zum Defekt sicherstellt. Werden die kleinen Korrosionsbekämpfer schließlich nicht mehr gebraucht, weil das Problem behoben ist, soll die Freisetzung wieder beendet werden. Der Clou zum Schluss: Die Beschichtung verschließt ihre Verletzungen mit eigenen Hilfsmitteln. Sie heilt sich selbst. Gesucht wird also eine Art „Wunder-Beschichtung“.

Michael Rohwerder, Leiter der Forschungsgruppe Korrosion am Max-Planck-Institut für Eisenforschung in Düsseldorf, befasst sich seit gut 20 Jahren mit intelligenten selbstheilenden Beschichtungen. Er interessiert sich dabei vor allem für selbstständig leitfähige Polymere wie Polyanilin und Polypyrrol. Solche Polymere besitzen konjugierte Doppelbindungen und leiten ähnlich gut wie Metalle. Sie verhalten sich damit konträr zu den meisten Kunststoffen, die Nichtleiter sind. Die Leitfähigkeit ist über Oxidation und Reduktion reversibel veränderbar: Polypyrrol kann vom reduzierten (nicht-leitenden) Zustand in den halb-oxidierten (leitenden) Zustand und wieder zurück wechseln (Abb. A). Diese Eigenschaften machte sich Rohwerder für die Entwicklung intelligenter selbstheilender Beschichtungen zunutze. Seine Grundidee war dabei von Anfang an: Das Trigger-Signal, das die Freisetzung des Inhibitors einleitet, soll ein Vorgang sein, den Korrosion immer verursacht: das Sinken des Elektrodenpotenzials im Metall, wenn die Korrosion beginnt. Genau dafür sind elektrisch leitende Polymere ideal, weil sie wegen ihrer Leitfähigkeit auf dieses Signal reagieren.

Abb. A: Polypyrrol. Die Abbildung zeigt Ausschnitte aus dem Polymer. Bei der Oxidation werden dem Polypyrrol Elektronen entzogen und positive Ladungen erzeugt. Für den notwendigen Ladungsausgleich sorgen eingelagerte Anionen (A–). Im halb-oxidierten Zustand (unten) ist das Polypyrrol leitend. In der reduzierten Form (oben) ist es nicht-leitend.

© MPG // HNBM-design.de // CC BY-NC-SA 4.0

Für die Entwicklung einer intelligenten Beschichtung musste im ersten Schritt der Inhibitor in der Schutzschicht gespeichert werden, erst bei Korrosion des darunterliegenden Metalls sollte er freigesetzt werden. In sämtlichen Versuchsreihen, vom Start im Jahr 2002 bis heute, wurde als korrodierende Metallschicht Zink verwendet, weil in der industriellen Fertigung für hochwertige Anwendungen auch meist eine Zinkschicht über dem Stahl liegt. Zuerst testete Rohwerder einen negativ geladenen Inhibitor. Die Teilchen waren als Gegenionen zur positiven Ladung des leitfähigen Polymers direkt in der Schicht eingelagert. Aber es klappte nicht so richtig, da die Inhibitor-Teilchen in zu geringen Mengen freigesetzt wurden. Einen neuen Ansatz für die Speicherung fand Rohwerder in den späteren Versuchen ab 2010. Die Inhibitor-Teilchen wurden nun in Kapseln mit Hüllen aus leitfähigem Polymer eingebettet. „In Kapseln lässt sich bei gleichem Volumen mehr davon speichern als direkt in der Polymerschicht“, erklärt Rohwerder den Vorteil der Kapsel-Methode. „Direkt im Polymergerüst sind die Inhibitor-Teilchen ja nur als Gegenionen zur positiven Ladung gespeichert, was einen kleinen Volumenanteil ausmacht. Im Kapselinneren dagegen können sie das ganze verfügbare Volumen einnehmen.“

Abb. B: Wiederverschließbare Behälter. Die Kapselwände (grün) bestehen aus leitfähigem Polymer. Durch Reduktion werden diese porös und die Inhibitor-Teilchen (rote Kugeln) verlassen die Kapsel. Erfolgt eine Rückoxidation des Polymers, schließen sich die Poren in der Kapselwand wieder.

© MPG // HNBM-design.de // CC BY-NC-SA 4.0

Als nächstes untersuchte Rohwerder die Freisetzung der Wirkstoffe. Bei den Experimenten wurde in die Polymerschicht bis zur Zinkschicht hineingeschnitten und etwas Salzlösung auf die offene Stelle getropft. Durch die beginnende Korrosion an der Zinkschicht sinkt das Elektrodenpotenzial und breitet sich aus. Die Kapselwände aus leitfähigem Polymer werden reduziert und hydrophiler. Die Kapseln nehmen bei dem Vorgang Kationen und Wassermoleküle aus der Salzlösung auf, die aus dem Defekt herüberströmen. In der Folge nimmt das Volumen der Kapseln zu, die Wände werden porös und durchlässig, so dass die Inhibitor-Teilchen freigesetzt werden (Abb. B). Der erste große Durchbruch.

Jetzt ließen sich die Wirkstoffe sicher in den Kapseln speichern, sogar in ausreichend großen Mengen. Und es gab ein Trigger-Signal, das sich vom Defekt im Zink über die Polymerschicht zu den Kapseln ausbreitete, wodurch die Wirkstoffe freigesetzt wurden. Aber damit war der Anti-Korrosions-Mechanismus noch nicht komplett. In der aktuellen Forschungsphase geht es nun darum, den Transport der Wirkstoffe sicherzustellen und möglichst noch zu beschleunigen. Zuerst der Transport selbst: Wie gelangen die Inhibitor-Teilchen durch die Polymerschicht zum Defekt im Zink, nachdem sie aus den Kapseln freigesetzt worden sind? Durch Reduktion wird die Polymerschicht, genau wie die Kapselwände, hydrophil und erleichtert damit den Transport der Inhibitor-Teilchen. Dieser erfolgt vor allem durch Diffusion. Die freigesetzten Wirkstoff-Teilchen diffundieren entlang eines Konzentrationsgefälles. Auf diese Weise gelangen sie vom Ort ihrer Freisetzung, an dem eine hohe Teilchenkonzentration vorliegt, bis zur Korrosionsstelle (Abb. C). Haben die Inhibitor-Teilchen der Korrosion Einhalt geboten, steigt das Elektrodenpotenzial im Defekt wieder an, da das Zink passiviert wird. Das führt zu einer Rückoxidation der Polymerschicht und der Kapselwände mit Luftsauerstoff. Die porösen Kapselwände schließen sich wieder.

Abb. C: Selbstheilende Schicht. In der Schutzschicht aus leitfähigem Polypyrrol (gelb) stecken Kapseln, deren Wände (grün) aus leitfähigem Polyanilin bestehen. Die Kapsel enthalten die Inhibitor-Teilchen (rote Kugeln). In vielen Arbeiten wurde 3-Nitrosalicylat verwendet, das gut auf Zink wirkt. Unter der Polymerschicht liegt die Zinkschicht. Bei den Experimenten wird in die obere Beschichtung hineingeschnitten und etwas Salzlösung auf die offene Stelle getropft (1). So beginnt das Zink unter dem Schnitt zu korrodieren (2). Dadurch sinkt das Elektrodenpotenzial – das entscheidende Trigger-Signal, welches sich vom Defekt im Zink bis zur Polymerschicht und den darin eingebetteten Kapseln ausbreitet (3). Die Kapseln nehmen Kationen und Wassermoleküle auf, die Kapselwände werden porös und durchlässig. Die freigesetzten Inhibitor-Teilchen diffundieren anschließend zum Defekt (4).

© MPG // HNBM-design.de // CC BY-NC-SA 4.0

Auch die Frage, wie beim Transport das nötige Tempo erreicht wird, ließ sich in den jüngsten Versuchen klären. Bei einem leitfähigen Polymer ist die Beweglichkeit der Inhibitor-Teilchen in der Schicht zunächst eingeschränkt. Sie erhöht sich aber stark, sobald das Polymer reduziert wird und Wassermoleküle aufnimmt. Über die Reduktion wird die Polymerschicht gleichsam von Tempo-30-Zone auf Schnellstraße geschaltet. „Der Trigger, das absinkende Elektrodenpotenzial, bewirkt also nicht nur die Freisetzung der Inhibitor-Teilchen aus den im Polymer eingelagerten Kapseln, sondern auch deren zügigen Transport“, fasst Rohwerder zusammen. Damit hat er den nächsten Durchbruch geschafft.

Und wie steht es um die Selbstheilung der Beschichtung als krönender Abschluss? Auch daran arbeitet Rohwerder zur Zeit. „Das Bilden einer neuen Polymerhaut ist keine ganz einfache Sache.“ Eine Möglichkeit besteht darin, Monomere zu polymerisieren. Diese können auch gut in leitfähigen Polymerkapseln gespeichert und auf das Trigger-Signal hin freigesetzt werden. Jedoch benötigt die Polymerisierung noch einen Katalysator. Die Katalysator-Teilchen sind allerdings durch die Einkapselung nicht gut genug geschützt vor Wasser und Sauerstoff. „Sie würden schon nach wenigen Tagen oder Wochen oxidiert werden“, sagt Rohwerder. Daher hat er sich einen Trick ausgedacht: Die Kapseln mit den Katalysator-Teilchen werden nicht in der Polymerschicht gespeichert, sondern in der Zinkschicht darunter. Beginnt dann die Korrosion, werden die Katalysator-Teilchen freigesetzt und ermöglichen die Polymerisierung der ebenfalls freiwerdenden Monomere. So bildet sich direkt an der defekten Stelle neues Polymer. Wie bei uns Menschen, wenn wir uns in den Finger geschnitten haben und die Wunde langsam wieder heilt, indem sich am Schnitt neue Haut bildet.

Auch für das Aufspüren von Defekten lässt sich ein cleverer Mechanismus in der Polymerschicht nutzen. Mit Sensoren aus organischen Kohlenstoffverbindungen, welche in porösen, nicht leitfähigen Siliziumdioxidkapseln in der Beschichtung stecken. Sie machen Korrosion sichtbar, indem die betroffenen Stellen zu glimmen beginnen, wenn der Stahl von außen mit UV-Licht bestrahlt wird. „Solche Sensoren würden Überprüfungen viel einfacher machen, weil sich die Korrosion schon nachweisen ließe, bevor sie mit bloßem Auge sichtbar wird“, sagt Rohwerder. Sonst wird Korrosion erst im fortgeschrittenen Stadium erkannt, wenn sich schon Blasen im Lack gebildet haben oder rötliche Rostverfärbungen zu sehen sind. Bei sehr dicken Beschichtungen wird bei Kontrollen sogar die Beschichtung entfernt, um zu schauen, wie es darunter aussieht. Mit den eingebauten Sensoren wäre das nicht mehr nötig.

Was da in Düsseldorf passiert, ist Grundlagenforschung. Sie schafft die Voraussetzungen, dass intelligente Beschichtungen in der Zukunft bei Brücken und Schiffen zur Anwendung kommen können. Stabil funktionierende Lösungen zu finden, erfordert eine Menge Zeit und noch mehr Ausdauer, weil sich Ansätze, die zuerst vielversprechend erscheinen, manchmal als falsch erweisen. Dann heißt es: Die Erfahrungen mitnehmen und neue Ideen ausprobieren. Diese „Umwege“ gehören zur Grundlagenforschung dazu und führen letztlich zu Fortschritten oder gar Durchbrüchen. Rohwerder ist mit dem bisher Erreichten zufrieden: „Es sind sicher noch Verbesserungen nötig, etwa für das erfolgreiche Verschließen großer Defekte. Auch muss die Beschichtung ja zehn Jahre oder länger halten und darf nicht zu teuer sein. Aber wir kommen dem Ziel, völlig neuartige selbstheilende Beschichtungen zu entwickeln, immer näher.“

Zwar gibt es schon Beschichtungen auf dem Markt, die als selbstheilend bezeichnet werden. Aber diese haben große Schwächen, zum Beispiel brauchen sie Wärme zum Selbstheilen. „Was wir vorschlagen, sind weitreichende Neuerungen. Die gibt es noch gar nicht.“ Und es wird auch lange dauern bis zur industriellen Fertigung. Unter anderem, weil das ganze heutige Beschichtungssystem für Stahl geändert werden müsste. Der Nutzen wäre aber riesengroß, ist sich Rohwerder sicher. Die aufwändige und umständliche Wartung von Brücken oder Flugzeugen würde mit intelligenten selbstheilenden Beschichtungen viel weniger Geld verschlingen. Und die Lebensdauer von Stahl würde sich deutlich erhöhen. Was auch dem Klima zugutekäme, denn die CO2-Emissionen bei der Erzeugung von Stahl sind enorm. Hielte das Material länger, müsste weniger neu produziert werden. In punkto Umweltschutz ergäben sich ebenso große Vorteile. „Die meisten hochwirksamen Wirkstoffe gegen Korrosion haben ja eine gewisse chemische Aktivität“, erklärt Rohwerder. Zum Beispiel der effektive Korrosionsbekämpfer Chromat – eine für die Umwelt toxische Substanz, die in Europa weitestgehend verboten ist. Andere Inhibitoren sind ebenfalls ein Umweltproblem oder könnten in Zukunft ein solches werden. Es ist also nie gut, wenn mehr als unbedingt nötig von diesen Substanzen freigesetzt wird. Und da punkten intelligente Beschichtungen. Sie lassen die Wirkstoffe nur bei Korrosion und nur an der betroffenen Stelle frei, was die Menge an Chemikalien, die in die Umwelt gelangen, auf das Nötigste begrenzt. Die Suche nach der Wunder-Beschichtung mag mühsam sein, aber sie lohnt sich auf jeden Fall.

Abbildungshinweise:

Titelbild: © Stefan Alfonso / iStock

Abb. A, B und C: © MPG // HNBM-design.de // CC BY-NC-SA 4.0

Der Text wird unter CC BY-NC-SA 4.0 veröffentlicht.

TECHMAX-Ausgabe 19, aktualisiert im Winter 2022; Autor: Andreas Lorenz-Meyer; Redaktion: Tanja Fendt

© Julia Knop / Max-Planck-Gesellschaft

Unwetter, Dürren, Überschwemmungen: Klaus Hasselmann hat ein Modell entwickelt, wie kurzfristige Wetterphänomene und langfristige Entwicklungen des Klimas zusammenhängen. Darüber hinaus wies er mit anderen Forschenden erstmals nach, dass der Anstieg der CO2-Konzentration in der Atmosphäre eine Erderwärmung verursacht. Dafür erhielt Klaus Hasselmann, ehemaliger Direktor am Max-Planck-Institut für Meteorologie in Hamburg, gemeinsam mit Syukuro Manabe (USA) und Giorgio Parisi (Italien) den Nobelpreis für Physik 2021.

Zum Podcast vom 3. Oktober 2022 (5 min) © Max-Planck-Gesellschaft

Themen im Podcast: Brownsches Bewegungsmodell, stochastisches Klimamodell, Erdklima, Ozeanographie, Rückkopplungen, Signalverarbeitung und Mustererkennung, „Fingerabdruck“ CO2

Hintergrundinformationen zur Forschung von Klaus Hasselmann

© wachiwit/Adobe Stock

Unser gesamtes Leben baut auf Fotosynthese auf. Die musste sich im Laufe der Zeit an große Veränderungen in der Umwelt anpassen. Eine neue Studie zeigt, wie dies das Enzym Rubisco geschafft hat und was die Erkenntnis darüber für die zukünftige Fotosynthese und auch unser Klima bedeuten kann.

Themen im Podcast: Enzym Rubisco / Fotosynthese / Anpassungen der frühen Fotosynthese / Rubisco-Varianten / Proteinstammbaum / Opitimierung Rubisco

Zum Podcast vom 24. Oktober 2022 (13 min) © detektor.fm/Max-Planck-Gesellschaft

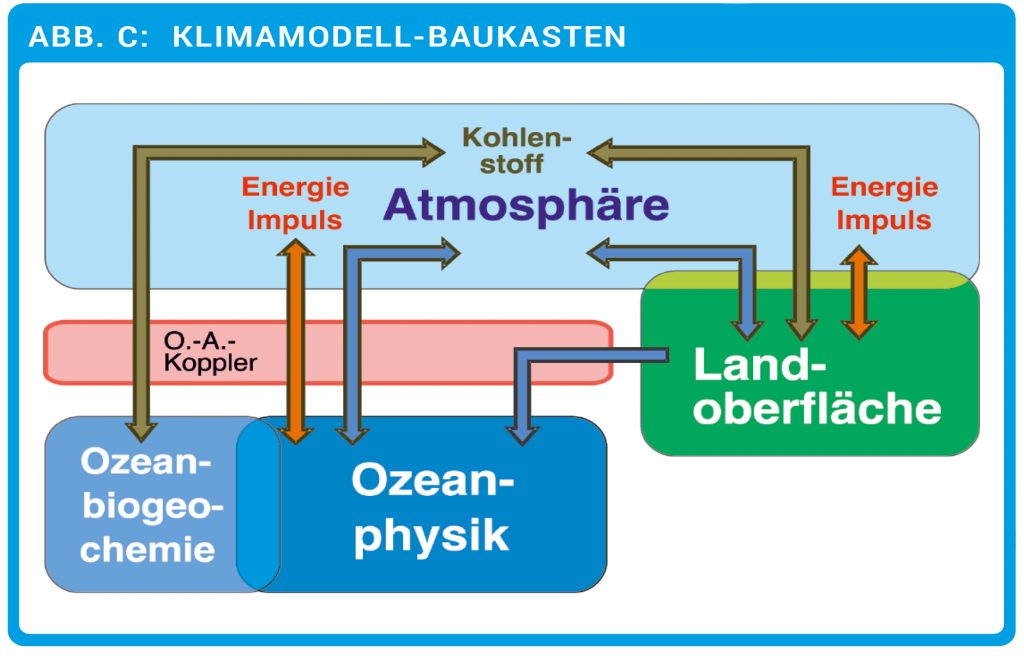

Module eines Klimamodells, wie sie am MPI für Meteorologie entwickelt und eingesetzt werden. Die einzelnen Elemente (farbige Boxen) werden über den Austausch von Energie, Impuls, Wasser und Kohlenstoff miteinander gekoppelt. Das „O.-A.-Koppler“-Modul (rot) simuliert den besonders wichtigen Austausch zwischen Ozean und Atmosphäre. Physikalische, biologische, chemische und geologische Prozesse werden berücksichtigt. Eine zentrale Rolle spielt der Kohlenstoffkreislauf (braune Pfeile, siehe auch Geomax 22).

© MPI für Meteorologie / CC BY 4.0

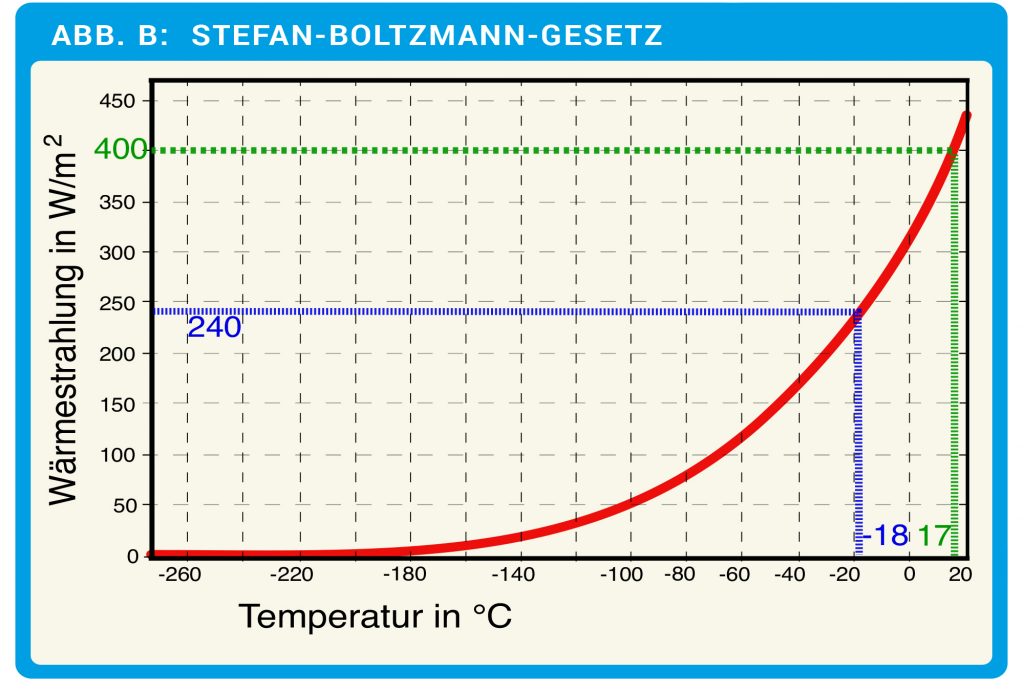

Das Stefan-Boltzmann-Gesetz beschreibt, welche Wärmestrahlung ein idealer schwarzer Körper in Abhängigkeit von der Temperatur abstrahlt. Für die Erde ist das zwar eine Idealisierung, kommt aber ihrem Verhalten sehr nahe. Eingezeichnet sind hier die Strahlungsleistungen bei -18 °C (ohne Treibhausgase) und den 17 °C nach dem einfachen Modell von Abb. A, Fall C. Die tatsächliche, global gemittelte Bodentemperatur liegt bei ungefähr 15 °C, also etwas darunter.

© R. Wengenmayr / CC BY-NC-SA 4.0

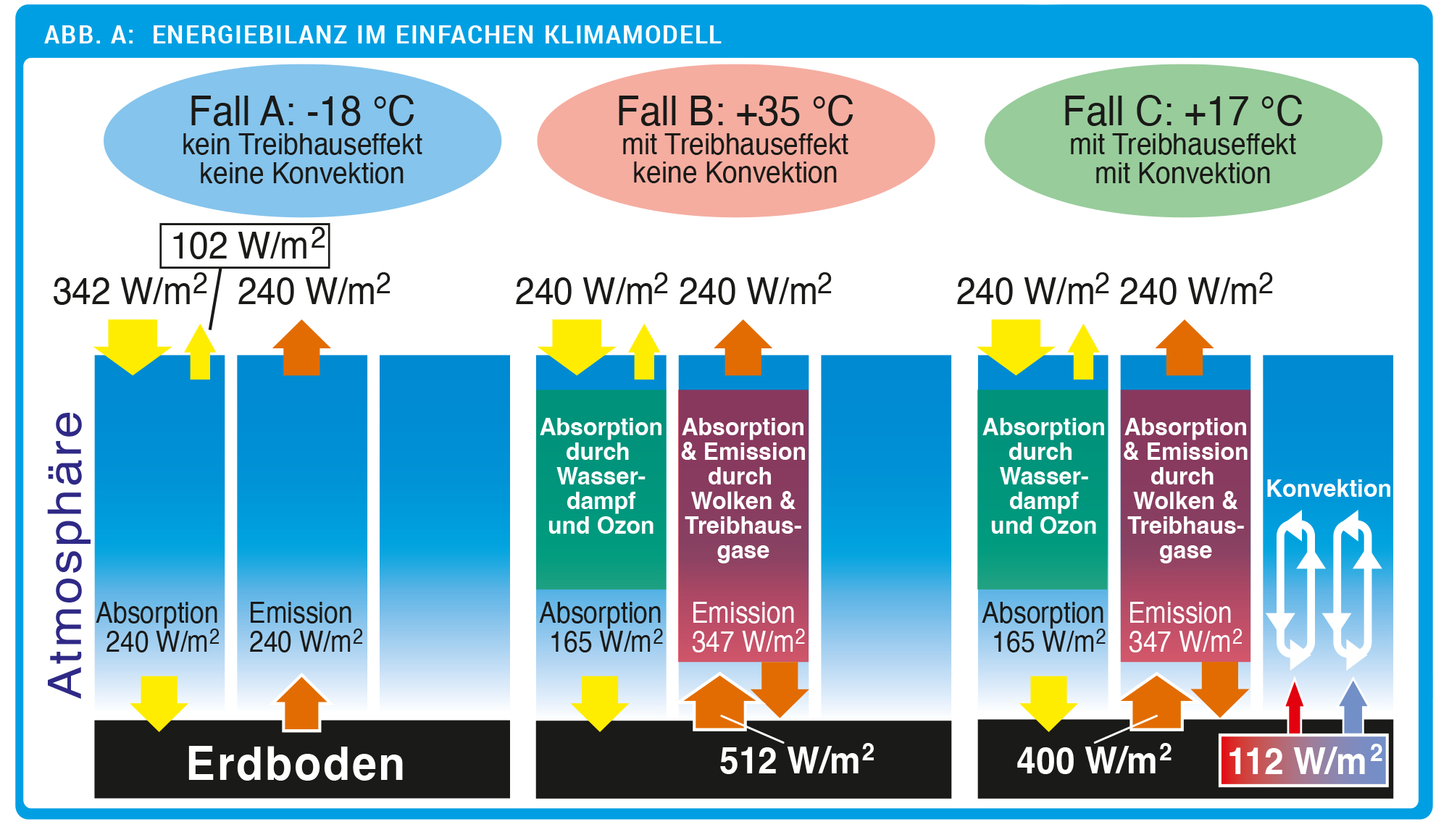

Die Fälle der Energiebilanz in der Erdatmosphäre werden von A bis C genauer. Die drei Säulen pro Fall zeigen jeweils von links nach rechts: Solarstrahlung, Abstrahlung des Bodens, Konvektion. Die Konvektion ist nur im Fall C berücksichtigt, der rote Pfeil symbolisiert die Wärmeenergie der Luft, der blaue Pfeil die im Dampf gespeicherte latente Wärme. Fall C ergibt eine global gemittelte Bodentemperatur von durchschnittlich 17 °C, was schon sehr nahe an den realen 15 °C ist.

© A. Kleidon, R. Wengenmayr / CC BY-NC-SA 4.0

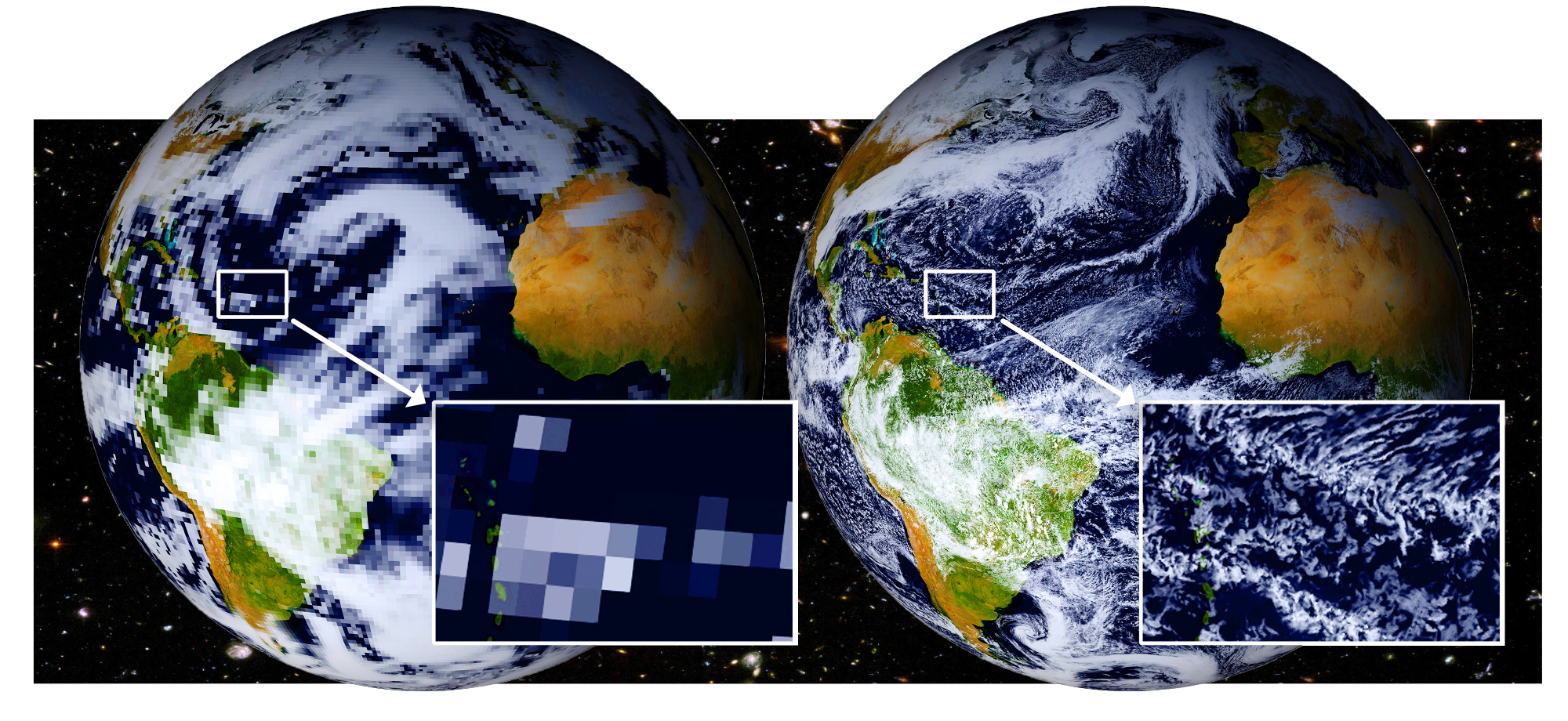

Simulation einer Wetterlage mit zwei Klimamodellen. Das Modell mit Zellen von 2,5 km Breite (rechts) erfasst die Wolkenstrukturen viel feiner als das Modell mit 80-km-Zellen (links). Das ermöglicht genauere Klimavorhersagen.

© F. Ziemen, DKRZ

„Es ist eindeutig, dass der Einfluss des Menschen die Atmosphäre, die Ozeane und die Landflächen erwärmt hat“, stellt der Sachstandsbericht 6 (AR6) des Weltklimarats IPCC fest: „Eine globale Erwärmung von 1,5 °C und 2 °C wird im Laufe des 21. Jahrhunderts überschritten werden, außer es erfolgen in den kommenden Jahrzehnten drastische Verringerungen der CO2– und anderer Treibhausgasemissionen.“ Solche Kernaussagen sind das Ergebnis einer weltweiten Zusammenarbeit von 270 Forschenden aus verschiedenen Spezialgebieten. Mit dabei ist Jochem Marotzke, Direktor am Max-Planck-Institut für Meteorologie in Hamburg. Der AR6-Bericht basiert auf vielen Messdaten, Beobachtungen sowie Klimamodellen, wie sie Marotzke mit seiner Abteilung entwickelt.

Die Lage ist ernst, aber Jochem Marotzke legt Wert darauf, der jungen Generation Mut zu machen. Es sei nicht zu spät, betont er, wir können etwas gegen die weitere Klimaerwärmung tun. Physikalische Gesetze schaffen die Grundlage, dass wir eine lebensfeindliche Heißzeit verhindern können. „Es wäre also ein fataler Fehler, in eine Angstlähmung zu verfallen, denn dann handelt man nicht.“ Handeln müssen wir aber, denn eines ist klar: Solange wir Menschen weiter Kohlenstoffdioxid ausstoßen, wird es wärmer. Je schneller wir unseren Ausstoß an Treibhausgasen in der Gesamtbilanz auf „Netto-Null“ herunterschrauben können, desto früher wird auch die Erderwärmung gestoppt. Netto-Null heißt, dass der dann noch vorhandene Treibhausgas-Ausstoß der Menschheit vollständig mit nachhaltigen Maßnahmen ausgeglichen wird.

Wer in das Gebiet der Klimamodelle eintauchen will, muss zuerst verstehen, wie das komplexe Klimasystem der Erde grundsätzlich funktioniert. Und wie der Mensch es beeinflusst. Dabei hat die Physik ihren Auftritt, denn beim Erdklima geht es global gesehen um eine Bilanz von Energieflüssen. Diese lassen sich in Watt pro Quadratmeter ausdrücken. Axel Kleidon, Klimaforscher am Max-Planck-Institut für Biogeochemie in Jena, hat ein physikalisches Modell mit drei Fällen aufgestellt. Für die Energiezufuhr sorgt die Sonne. Ihre Strahlung trifft auf die Erdatmosphäre, mit einem globalen Mittelwert von 342 W/m2 (Abb. A, Fall A). Davon werden durch Schnee und Eis auf der Erdoberfläche und durch Wolken 102 W/m2, also knapp 30 %, zurück ins Weltall reflektiert. Es verbleiben somit 240 W/m2, die auf den Erdboden treffen und ihn aufwärmen. Sobald sich ein Gleichgewicht eingestellt hat, strahlt der Boden die 240 W/m2, umgewandelt in Form von Infrarotstrahlung, wieder ins Weltall ab. In diesem Fall A würde sich die Bodentemperatur theoretisch bei einem globalen Mittelwert von –18 °C einpendeln. Das kann man mit Hilfe der sogenannten Schwarzkörper-Strahlung ausrechnen, die das Stefan-Boltzmann-Gesetz beschreibt. Ohne Treibhauseffekt wäre die Erde also eingefroren. „Tatsächlich würde sie sogar noch kälter werden“, sagt Jochem Marotzke. Die einfache Abschätzung berücksichtigt nämlich nicht, dass die durch Eis und Schnee hellere Oberfläche mehr Sonnenstrahlung als heute ins All zurückreflektieren würde. Dieses Rückstrahlvermögen heißt Albedo, und eine „Schneeballerde“ hätte eine viel größere Albedo als die heutige Erde.

Abb. A: Energiebilanz im einfachen Klimamodell. Die Fälle der Energiebilanz in der Erdatmosphäre werden von A bis C genauer. Die drei Säulen pro Fall zeigen jeweils von links nach rechts: Solarstrahlung, Abstrahlung des Bodens, Konvektion. Die Konvektion ist nur im Fall C berücksichtigt, der rote Pfeil symbolisiert die Wärmeenergie der Luft, der blaue Pfeil die im Dampf gespeicherte latente Wärme. Fall C ergibt eine global gemittelte Bodentemperatur von durchschnittlich 17 °C, was schon sehr nahe an den realen 15 °C ist.

© A. Kleidon, R. Wengenmayr / CC BY-NC-SA 4.0

Davor rettet uns der natürliche Treibhauseffekt, zusammen mit den Wolken. „Das wirkt wie ein warmer Mantel um die Erde“, sagt Marotzke. Wenn das Licht der Sonne in die Atmosphäre eindringt, absorbieren zunächst Ozon und Wasserdampf einen Teil davon, sodass im globalen Mittel nur 165 W/m2 den Boden erreichen (Abb. A, Fall B). Der eigentliche Treibhauseffekt entsteht, sobald die vom Boden ausgesandte Infrarotstrahlung sich auf den Weg ins Weltall macht. Sie trifft nun wieder auf Wassermoleküle, CO2 und weitere Treibhausgase. Moleküle, die aus drei und mehr unterschiedlichen Atomen bestehen, absorbieren wie kleine Antennen Energie aus der langwelligen Infrarotstrahlung. Diese Energie geben sie über Stöße an die Nachbarmoleküle in der Luft ab, und deren stärkere Bewegung lässt die Temperatur der Atmosphäre steigen. Obwohl Treibhausgase nur Spurengase geringer Konzentration in der Atmosphäre sind, entfalten sie so eine große Wirkung. Sie senden nun selbst mehr Infrarotstrahlung zur Erdoberfläche zurück, im globalen Mittel 347 W/m2. Als Folge erwärmt sich der Boden immer weiter, strahlt aber auch stärker im Infraroten ab. Schließlich stellt sich bei einer Bodenabstrahlung von 512 W/m2 ein neues Gleichgewicht in der Strahlungsbilanz ein. Dadurch steigt nun allerdings die Lufttemperatur am Boden auf einen globalen Mittelwert von 35 °C!

Das ist viel zu warm im Vergleich zur realen Erde. Es fehlt noch ein dritter, stark kühlender Mechanismus der Atmosphäre und der Erdoberfläche (Abb. A, Fall C): die Konvektion. Ihre Bedeutung erkannte der japanisch-amerikanische Klimaforscher Syukuro Manabe, als er Anfang der 1960er-Jahren erste, noch sehr einfache Klimamodelle entwickelte. Im Jahr 2021 erhielt er gemeinsam mit Klaus Hasselmann, dem Gründungsdirektor des Max-Planck-Instituts für Meteorologie, für Pionierarbeiten zur Klimaforschung den Nobelpreis für Physik. Konvektion entsteht, weil vom Boden aufgewärmte Luft wie ein Heißluftballon aufsteigt, sich in der Atmosphäre abkühlt und wieder herunterfällt. Dieser Kreislauf transportiert Wasserdampf hinauf zu den Wolken. Wenn Wasser aus dem Boden verdampft, nimmt es sehr viel Energie auf. Diese latente Wärme plus die Wärme in der aufgeheizten Luft werden dem Boden entzogen und kühlen ihn. So gelangen im Gleichgewicht zusätzliche 112 W/m2 in die Atmosphäre. Damit pendelt sich der globale Mittelwert der Bodentemperatur bei rund 17 °C ein. Kleidons einfache Abschätzung kommt dem tatsächlichen Wert von etwa 15 °C erstaunlich nahe. Der Fall C beschreibt das Klimasystem der Erde in einem Gleichgewicht vor dem Zeitalter der Industrialisierung. Danach begann der Mensch, immer mehr fossile Brennstoffe wie Kohle, später auch Erdöl und Erdgas, zu verbrennen. Dadurch gelangten zusätzliche Treibhausgase in die Atmosphäre, vor allem CO2. Dessen Konzentration ist seit 1750 durch menschliche Aktivitäten um etwa die Hälfte angestiegen.

„Dieser Treibhausgas-Ausstoß des Menschen wirkt wie eine zusätzliche Wärmedecke um die Erde“, sagt Marotzke. Entsprechend verschiebt sich das Gleichgewicht in der Bilanz der Strahlungsflüsse. Was da genau geschieht, will die Klimaforschung herausfinden. Entscheidend sind die Rückkopplungen im Klimasystem. Eine Rückkopplung ist die Albedo der Erdoberfläche, die abnimmt, wenn die hellen Eisflächen im wärmeren Klima schrumpfen. Sie beschleunigt somit die Erderwärmung, was durch einen positiven Rückkopplungsparameter beschrieben wird. Der aktuelle IPCC-Bericht nennt dafür einen geschätzten Zahlenwert von +0,35 W/(m2 • K). Den stärksten positiven Rückkopplungsparameter mit +1,3 W/(m2 • K) bringen zusätzlicher Wasserdampf und die Temperaturzunahme der Luft in die Bilanz ein. Wolken kommen mit +0,42 W/(m2 • K) dazu. Gäbe es also nur diese positiven Rückkopplungen im Klimasystem, dann würde die Erde tödliches Fieber bekommen.

Abb. B: Das Stefan-Boltzmann-Gesetz beschreibt, welche Wärmestrahlung ein idealer schwarzer Körper in Abhängigkeit von der Temperatur abstrahlt. Für die Erde ist das zwar eine Idealisierung, kommt aber ihrem Verhalten sehr nahe. Eingezeichnet sind hier die Strahlungsleistungen bei -18 °C (ohne Treibhausgase) und den 17 °C nach dem einfachen Modell von Abb. A, Fall C. Die tatsächliche, global gemittelte Bodentemperatur liegt bei ungefähr 15 °C, also etwas darunter.

© R. Wengenmayr / CC BY-NC-SA 4.0

Dem wirkt aber ein starker Kühlmechanismus entgegen: die negative Planck-Rückkopplung. Sie gleicht mit geschätzten -3,22 W/(m2 • K) alle positiven Rückkopplungen mehr als aus. Das gilt auch für den Effekt der zusätzlichen Treibhausgase aus auftauenden Permafrostböden. Unter Berücksichtigung der Rückkopplungen von Biosphäre und Geologie, die ebenfalls negativ wirken, kommt der AR6-Bericht in der Bilanz auf einen geschätzten Rückkopplungswert von -1,16 W/(m2 • K). Hinter dieser Rettung steckt die schon erwähnte Schwarzkörper-Strahlung. Damit lässt sich beschreiben, wie sich das Abstrahlverhalten der Erde mit der Temperatur (T) verändert. Die Formel dafür liefert die Physik in Form des Stefan-Boltzmann-Gesetzes: Danach steigt der in den Kosmos zurückgestrahlte Energiefluss mit T4 an! An diese Kurve (Abb. B) können wir bei der aktuellen, globalen Mitteltemperatur von 15 °C am Boden eine Gerade anlegen. Wäre die Erde ein einfacher Schwarzkörper, dann hätte die Gerade eine Steigung, die einem Wert von etwa 5,42 W/(m2 • K) entspräche. Diesen Wert müssen wir noch mit 0,6 multiplizieren. Der Faktor berücksichtigt, dass der Treibhauseffekt nur einen Teil der vom Boden abgestrahlten Wärmestrahlung ins Weltall entweichen lässt. Als Ergebnis erhält man fast genau den im IPCC-Bericht (AR6) angegebenen Wert von 3,22 W/(m2 • K) für die Planck-Rückkopplung.

Eine entscheidende Frage in diesem Zusammenhang ist, ob es im Klimasystem sogenannte „Kippelemente“ gibt und wo sie liegen. Ein Teil der Klimaforschenden geht davon aus, dass etwa die Permafrostböden oder das Eisschild von Grönland zu den Kippelementen zählen. Übersteigt die Klimaerwärmung einen gewissen Punkt, könnten diese unumkehrbar zu schmelzen beginnen. Welche Kippelemente es im Klimasystem möglicherweise gibt und bei welchem Anstieg der mittleren globalen Temperatur sie umkippen könnten, wird kontrovers diskutiert.

Hier kommt eine wichtige Größe ins Spiel: die Gleichgewichts-Klimasensitivität, abgekürzt ECS für „Equilibrium Climate Sensitivity“. Dieser Begriff geht auf eine Pionierarbeit zum Treibhauseffekt zurück, die der schwedische Physiker und Chemiker Svante Arrhenius 1896 veröffentlichte. Im Kern geht es um die Frage, wie sich die umhüllende Wärmedecke verhält, wenn das Klima wärmer wird. „Die Wirkung der ECS können wir uns in einem Gedankenexperiment vorstellen, in dem wir die CO2-Konzentration in der Atmosphäre verdoppeln“, sagt Marotzke: „Dann stellt sie die global gemittelte Erwärmung der Erdoberfläche dar, die sich langfristig im neuen Gleichgewicht einstellt.“

Eine der großen Herausforderungen besteht darin, den Wert der ECS einzugrenzen. Viele Jahre lang blieb sie hartnäckig in einer Spanne zwischen 1,5 und 4,5 °C stecken. Der AR6-Bericht konnte nun endlich diese Unsicherheit verkleinern, auf eine wahrscheinliche Spanne von 2,5 bis 4 °C. Diese Reduktion um 1,5 °C klingt nach nicht viel. Sie ist aber ein großer Schritt, um genauere Aussagen darüber machen zu können, wie viel Treibhausgase die Menschheit noch ausstoßen darf, um das Pariser Klimaziel von 1,5 °C einhalten zu können. Auf jeden Fall wird das knapp! Der globale Mittelwert der Bodentemperatur ist seit Beginn verlässlicher Wetteraufzeichnungen bereits um 1,2 °C angestiegen, in Deutschland seit 1881 sogar schon um 1,6 °C.

Das einfache physikalische Modell der Strahlungsbilanz (Abb. A) kann die mittlere Oberflächentemperatur verblüffend gut errechnen. Will man aber genauere Aussagen treffen, etwa über regionale Veränderungen, dann braucht man Klimamodelle. Davor beantwortet Jochem Marotzke noch die Frage, warum CO2 eine so dominante Rolle im Treibhaus der Erde spielt. Schließlich sorgt Wasserdampf für einen stärkeren Treibhauseffekt. „Der Wasserdampf ist aber sozusagen der Sklave des CO2“, entgegnet der Forscher. Ursache ist dessen kurze Aufenthaltsdauer im Klimasystem. Das Wasser in der Luft wird ungefähr alle zehn Tage komplett erneuert. „Das CO2 hingegen hat eine viel längere Verweildauer“, erläutert er. „Ein Viertel davon bleibt für Jahrhunderte in der Luft!“ Deshalb steuert das CO2 in seiner Trägheit das Klima, während der schnelllebige Wasserkreislauf sich an die Temperaturveränderung anpassen muss.

Diese Erkenntnis, dass im Klima ein schnelles System immer einem langsamen folgen muss, geht vor allem auf Klaus Hasselmann zurück. Der Nobelpreisträger baute darauf zwei bedeutende Pionierarbeiten auf. Darin untersuchte er das Zusammenspiel der Ozeane mit der Atmosphäre. Der riesige Wasserkörper der Meere reagiert sehr langsam auf Klimaveränderungen, er ist das Langzeitgedächtnis. Damit diktieren die langsamen Ozeane der viel schneller reagierenden Atmosphäre langfristige Klimatrends. Man kann das mit einem Menschen vergleichen, der einen unerzogenen Hund an der Leine hält. Der Hund rennt wild hin und her und lässt dadurch den Menschen scheinbar ziellos herumtorkeln. Wenn man länger zuschaut, sieht man jedoch, wie das langsame System Mensch das schnelle System Hund allmählich in die Richtung zwingt, in die der Mensch will. Wie aber kann man einen solchen Trend bereits im chaotischen Bewegungsmuster des Pärchens Mensch-Hund ausmachen, wenn er für das bloße Auge noch gar nicht erkennbar ist? Das entspricht der Frage, die sich Hasselmann gestellt hat: Wie kann man den menschlichen Klima-Handabdruck zweifelsfrei nachweisen, obwohl er sich als winziges Signal im chaotischen Rauschen der täglichen Wetterschwankungen verbirgt? Dieser Nachweis gelang dem Forscher in seiner zweiten Pionierarbeit.

„Klimamodelle kann man sich als digitale Zwillinge der Erde vorstellen“, führt Marotzke in sein Forschungsgebiet ein (Abb. C). Die Modelle können aber nicht jedes Wassertröpfchen oder gar Molekül nachbilden, das würde alle Supercomputer weit überfordern. Stattdessen besteht der digitale Zwilling aus einem erdumspannenden, dreidimensionalen Netz aus mathematischen Zellen. Diese Zellen erfassen die Atmosphäre, den Boden bis in eine Tiefe von etwa zehn Metern, sowie den Wasserkörper der Ozeane. Für jede Zelle wird bilanziert, welche Energie und welche Masse hinein- und wieder herausströmt. „Es geht also um Energie- und Impulsänderungen, um die Erhaltungssätze der Physik“, sagt der Forscher. Damit lässt sich ausrechnen, wie sich der Energie- und Impulsinhalt jeder Zelle ändert. „Aus dem Energieinhalt können wir die Temperatur ausrechnen, aus der Temperatur die Dichte und daraus den Luftdruck“, erklärt er weiter. Das führt wiederum zu den Windgeschwindigkeiten. In der Atmosphäre wird es allerdings dadurch kompliziert, dass Phasenübergänge stattfinden können: Wasser verdampft, kondensiert wieder zu Tröpfchen oder friert sogar aus.

Abb. C: Module eines Klimamodells, wie sie am MPI für Meteorologie entwickelt und eingesetzt werden. Die einzelnen Elemente (farbige Boxen) werden über den Austausch von Energie, Impuls, Wasser und Kohlenstoff miteinander gekoppelt. Das „O.-A.-Koppler“-Modul (rot) simuliert den besonders wichtigen Austausch zwischen Ozean und Atmosphäre. Physikalische, biologische, chemische und geologische Prozesse werden berücksichtigt. Eine zentrale Rolle spielt der Kohlenstoffkreislauf (braune Pfeile, s. auch Geomax 22).

© MPI für Meteorologie / CC BY 4.0

Das Computerprogramm rechnet nun in Zeitschritten die Mittelwerte für alle Zellen aus. Hierin unterscheiden sich Klimamodelle nicht von Wettermodellen. Allerdings müssen Klimamodelle in der Regel einige Jahrzehnte bis Jahrhunderte erfassen. Deshalb ist ihr Netz an Zellen viel grobmaschiger, um die Rechenleistung der Computer nicht zu sprengen. Als Folge fallen feine, aber wichtige Elemente des Klimasystems durch das Raster. Forschende müssen Schätzungen einsetzen, was die Genauigkeit reduziert. Außerdem starten Klimamodelle nicht mit Wetterdaten für einen Tag X, wie Wettermodelle. Stattdessen werden sie mit Annahmen über die Entwicklung von Treibhausgasen gefüttert. Diese beruhen auf verschiedenen Szenarien der gesellschaftlichen Entwicklung. Der AR6-Bericht arbeitet mit fünf Szenarien: Im extremen „Weiter-so“-Szenario steigt der CO2-Ausstoß der Menschheit ungebremst an, im günstigsten Szenario kann sie diese Emissionen sehr bald auf Netto-Null reduzieren. Im ersteren Fall würden wir am Ende des 21. Jahrhunderts bei einer um fast fünf Grad aufgeheizten Erde im Vergleich zur Mitte des 19. Jahrhunderts landen. Das Ergebnis wäre ein radikal veränderter Planet mit einigen Regionen, die wahrscheinlich nicht mehr bewohnbar wären.

Aber woher weiß man, wie gut ein Klimamodell funktioniert? Dazu muss es als Test die Klimaentwicklung der Vergangenheit simulieren (s. Geomax 19). Heutige Klimamodelle können das sehr genau. Ihre Problemzone ist die immer noch geringe Auflösung, typische Zellengrößen liegen bei 150 km. Das erschwert auch Aussagen über regionale Klimaentwicklungen. Deshalb forschen die Hamburger an hochauflösenden Klimamodellen, die mit viel feineren Zellen auch kleinräumige Prozesse in der Atmosphäre physikalisch genau beschreiben können. Im Projekt „Sapphire“ konnte ein Team um Cathy Hohenegger und Daniel Klocke am Institut schon großräumige Klimavorgänge in einer Auflösung von 2,5 Kilometern und noch feiner simulieren. Damit wird auch die Simulation von Wolken realistischer, die eine wichtige Rolle im Klima spielen (vgl. Titelbild). Eine schlankere Programmierung und leistungsfähigere Computer machen dies möglich.

In Zukunft werden Klimamodelle die Erde immer kleinräumiger erfassen können. Sie erlauben damit genauere Aussagen über die Folgen des menschlichen Handabdrucks im Klima. Das betrifft zum Beispiel regionale Zunahmen von Extremwetterlagen (s. Geomax 25). Eines ist klar: Jedes eingesparte Kilogramm CO2 ist eine Investition in die Zukunft!

Abbildungshinweise:

Titelbild: © F. Ziemen, DKRZ

Abb. A: © A. Kleidon, R. Wengenmayr / CC-BY-NC-SA 4.0

Abb. B: © R. Wengenmayr / CC-BY-NC-SA 4.0

Abb. C: © MPI für Meteorologie/ CC BY 4.0

Der Text wird unter CC BY-NC-SA 4.0 veröffentlicht.

TECHMAX 31, Herbst 2022; Autor: Roland Wengenmayr; Redaktion: Tanja Fendt