© IPP

Wie erzeugt und kontrolliert man ein 100 Millionen Grad heißes Plasma? Mit dieser für die Kernfusion elementaren Frage beschäftigt sich Thomas Klinger, Leiter der Forschungsanlage Wendelstein 7-X am Max-Planck-Institut für Plasmaphysik in Greifswald. Klinger spricht über den aktuellen Stand der Forschung und wagt einen Ausblick, ab wann tatsächlich Strom durch Kernfusion gewonnen werden könnte.

[6 min; deutsch]

Podcast vom 27. Juni 2018 © detektor.fm

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

YouTube-Link: https://youtu.be/amlfGc-oC0Y

Nirgendwo auf der Erde ist der Klimawandel so sichtbar wie in der Arktis. Doch das Eis der Arktis zeigt nicht nur die Klimaänderungen besonders deutlich, es ist auch selber ein bedeutender Faktor im Klimasystem. Forscher*innen des Max-Planck-Instituts für Meteorologie in Hamburg wollen deshalb die Rolle des Meereises und die Bedingungen für seine Bildung und Beständigkeit genau verstehen. Dazu messen sie unter anderem auf den Eisschollen die Dicke des Eises und seine Zusammensetzung aus Süßwassereis, Salzsole und Gaseinschlüssen.

[Dauer des Videos: 4 min]

Einblendung ab 2:30 – Copyright AF Expeditionen

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

YouTube-Link: https://youtu.be/X05ccQFGFrY

Der CO2-Gehalt in der Atmosphäre war seit Jahrhunderttausenden nicht mehr so hoch wie heute. Um den aktuellen Klimawandel besser verstehen und das künftige Klima genauer vorhersagen zu können, schauen die Forscher*innen des Max-Planck-Instituts für Chemie in Mainz oft in die Vergangenheit. Anhand von Sedimentproben können die Wissenschaftler sehen, wie sich die klimatischen Bedingungen vergangener Zeiten entwickelt und welche Konsequenzen diese Veränderungen für das Leben auf der Erde hatten.

[Dauer des Videos: 3 min]

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

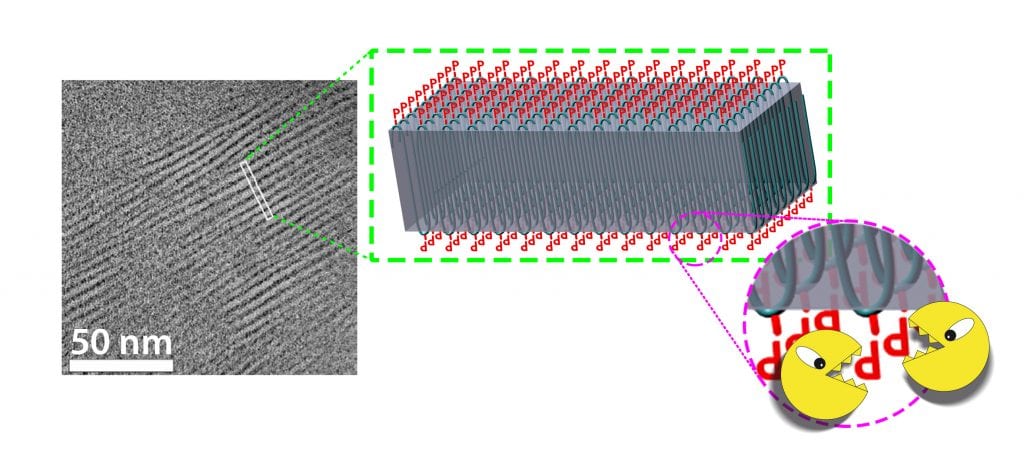

Das kleine rechteckige Feld (links) zeigt einen Ausschnitt aus einer elektronenmikroskopischen Aufnahme. In der Mitte ist dieser Ausschnitt vergrößert als Grafik im Schnittbild dargestellt. Man erkennt die Schlaufen des Polymers im Kristall. Außen an den Schlaufen sitzen die Phosphate (rotes P) als eingebaute Schwachstellen. An diesen sollen Mikroorganismen beim biologischen Abbau „knabbern“ können, so dass sich die Schlaufen auflösen (rechts).

© F. Wurm, R. Wengenmayr / CC BY-NC-SA 4.0

Veröffentlicht 2018

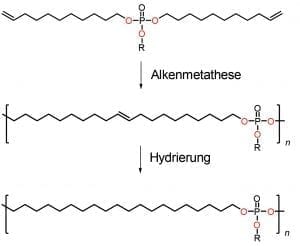

Oben ist das Monomer mit dem eingebauten Phosphat in der Mitte zu sehen (P steht für Phosphor, O für Sauerstoff, R für einen Molekülrest). Bei der Alkenmetathese werden aus vielen Monomeren lange Polymerketten (Mitte); n steht für die Anzahl der Monomere. Das nun entstandene Polymer enthält noch eine Doppelbindung. Der nächste Schritt – die sog. Hydrierung – erzeugt durch das Anbinden von Wasserstoffatomen das abbaubare Polyethylen (unten).

© F. Wurm, MPI für Polymerforschung / CC BY-NC-SA 4.0

© Valeria Hidalgo-Ruz / GAME 2013 / GEOMAR

Die Geschichte der Menschheit lässt sich nach ihren Werkstoffen in Epochen einteilen: Steinzeit, Bronzezeit, Eisenzeit. Die Epoche ab Mitte des 20. Jahrhunderts könnte als Plastikzeitalter in die Geschichte eingehen. Wir müssen nur einen Tag lang aufmerksam beobachten, wo uns Kunststoffe begegnen. Sie sind überall: in der Kleidung, in Brillen, Fenstern, Türen und Isolationen von Häusern, in elektronischen Geräten, Fahrzeugen und Verpackungen aller Art. Wir leben ganz offensichtlich im Plastikzeitalter. Kunststoffe sind einerseits ein Segen. Als geniale, leichte, verformbare und energiesparende Alleskönner erleichtern sie uns unser Leben. Auf der anderen Seite sind sie zu einem Problem geworden − wegen ihrer Haltbarkeit. Beim Urlaub am Meer schwappt einem das Plastikzeitalter geradezu entgegen: Auf den Stränden liegen angespülte Flaschen, Tüten, Plastikfetzen. Auf einigen Ozeanen schwimmen große „Plastikinseln“. Und der Nordatlantik wird zunehmend zur „Plastiksuppe“, die starke Strömungen permanent durchmischen.

Ein großer Anteil des Plastikmülls entfällt auf feine Mikropartikel aus Kunststoff. Dieses „Mikroplastik“ mit einer Größe von einigen Mikrometern – also Millionstel Meter – entsteht zum Teil durch Zerfall größerer Plastikteile. Andere Quellen sind verlorengegangenes Plastikgranulat, das Rohmaterial der Kunststoffindustrie, sowie feine „Schleifpartikel“ aus Kosmetika wie Zahnpasta oder Peelingcremes. Schweden zieht nun die Konsequenzen und verbietet zum 1. Juli 2018 den Verkauf solcher Kosmetikprodukte. Viel Mikroplastik wird etwa auch aus Funktionskleidung frei, die in Waschmaschinen durchgewalkt wird oder beim Abrieb von Reifen, den Regen durch die Kanalisation ins Abwasser spült. Da Kläranlagen Mikroplastik nicht völlig aus dem Wasser entfernen können, gelangt einiges davon in Flüsse und schließlich Ozeane.

Nach Untersuchungen der internationalen Naturschutzorganisation IUCN werden jedes Jahr zwischen 0,8 und 2,5 Millionen Tonnen Kunststoff-Mikropartikel in die Ozeane gespült. Und amerikanische Forscher der Universität Georgia haben herausgefunden, dass die Menge an Plastikmüll jeder Art weltweit jährlich um 4,8 bis 12,7 Millionen Tonnen anwächst. Angesichts solcher Zahlen wird klar, dass wir Menschen unseren Planeten auch mit Kunststoffen verändern. Plötzlich taucht überall ein Material auf, das es in der Erdgeschichte zuvor nicht gab. Es ist also höchste Zeit, die möglichen Folgen genauer zu erforschen. Von zerkleinerten Plastikteilen wissen wir, dass Meeresschildkröten und viele Seevögel sehr darunter leiden. Sie verwechseln diese mit Nahrung und müssen dann verhungern, weil der unverdauliche Müll ihre Mägen verstopft.

„Bei den Kunststoff-Mikropartikeln dagegen ist noch nicht klar, inwieweit sie für Menschen und Tiere gefährlich sind“, erklärt Frederik Wurm. Es könnte gut sein, dass das Mikroplastik einfach wie Sand durch die Verdauungsorgane von Organismen hindurchwandert, ohne Schaden anzurichten. Frederik Wurm ist Chemiker und leitet die Gruppe „Funktionelle Polymere“ am Max-Planck-Institut für Polymerforschung in Mainz. Mit einem Teil seines Teams macht er im Forschungsprojekt PlastX mit, das vom Bundesforschungsministerium gefördert wird. Auch die Verbraucherzentrale Nordrhein-Westfalen, die Gesellschaft für Internationale Zusammenarbeit und die Supermarktkette Tegut unterstützen PlastX. Das zeigt schon, wie viele verschiedene Lebensbereiche das Thema Plastikmüll betrifft. Deshalb sind an PlastX auch unterschiedliche Forschungsrichtungen beteiligt: Sozioökonomen von der Goethe Universität Frankfurt untersuchen das Konsumverhalten der Menschen. Sie versuchen Wege aufzuzeigen, wie man das Wegwerfverhalten ändern könnte. Gerade in ärmeren Gesellschaften ist das „wilde Entsorgen“ ein Problem. Ökotoxikologen erforschen, ob Mikroplastik für Organismen schädlich sein könnte. „Derzeit füttern sie Daphnien, kleine Wasserflöhe, damit und schauen, ob ihnen das schadet“, erzählt Wurm. Er ist begeistert von der engen Zusammenarbeit mit Kolleginnen und Kollegen aus verschiedenen wissenschaftlichen Disziplinen.

Die Mainzer Chemiker entwickeln Ideen für neue Kunststoffe, die in der Umwelt abbaubar sind. Ihre Materialproben werden dann auch von den Frankfurtern an Wasserflöhen getestet. Allerdings ist die Herausforderung der biologischen Abbaubarkeit viel komplizierter, als Wurm anfangs dachte. Was heute zum Beispiel als „Biokunststoff“ vermarktet wird, ist nämlich nicht „bio“, wenn es unkontrolliert in die Umwelt gelangt. Nur bei den hohen Temperaturen, die in industriellen Kompostierungsanlagen herrschen, zersetzen sich solche Kunststoffe. „Der heute von der Werbung verwendete Begriff Bioplastik ist also eigentlich irreführend“, sagt Wurm.

Aber was sind Kunststoffe, chemisch gesehen? Es sind sogenannte Polymere, lange Ketten, die aus vielen kleineren, immer gleichen Molekülbausteinen bestehen. Diese Bausteine heißen Monomere. Ein Kunststoff enthält aber noch verschiedene Zusätze, „Additive“, etwa Farbstoffe. Die beiden aus Umweltsicht wichtigsten Additive sind Weichmacher und Flammschutzmittel. Weichmacher machen, wie der Name schon sagt, die Kunststoffe erst flexibel, sodass sie sich etwa zu Folien verarbeiten lassen. In reiner Form sind viele Polymere eher spröde, hart und in Teilen sogar kristallin.

Da die meisten Kunststoffe brennbar sind, enthalten sie Flammschutzmittel. Diese Substanzen machen je nach Kunststoff bis zu fünfzig Prozent seines Gewichts aus. „Das sind meist Organophosphate, auch Phosphorsäureester genannt, und Halogenkohlenwasserstoffe“, erklärt Wurm: „Und die sind potenziell giftig.“ Solche Flammschutzmittel sind für die Mainzer ein wichtiges Forschungsgebiet, denn sie sind spezialisiert auf Phosphorchemie. Derzeit forschen sie auch an alternativen Phosphorverbindungen, die als Flammschutzmittel biologisch abbaubar und möglichst unbedenklich sind.

Die Kunststoffsorten, die weltweit am meisten verwendet werden, basieren auf dem enorm vielseitigen Polyethylen (PE). „Davon werden ungefähr hundert Millionen Tonnen pro Jahr produziert“, sagt Wurm. Aus PE werden vor allem Verpackungen gemacht, aber auch viele andere Dinge, etwa Wasserrohre oder Teile für Gelenkprothesen. Wie der Name schon sagt, sind im Polyethylen viele Ethen-Monomere miteinander zu langen Ketten verbunden. Ethen wurde früher Ethylen genannt. Herstellen lässt es sich zum Beispiel aus Ethan, dem Hauptbestandteil von Erdgas. Das Ethen-Molekül besteht aus zwei Kohlenstoffatomen (C) und vier Wasserstoffatomen (H), wobei die beiden Kohlenstoffatome über eine Doppelbindung fest zusammenhalten. Das ergibt die chemische Formel H2C=CH2 für ein Ethen-Monomer. Die chemische Reaktion beim Polymerisieren bricht nun diese Doppelbindung auf. Sie verknüpft über die freiwerdenden zwei Einzelbindungen wie mit Steckern die benachbarten Monomere. Wichtig sind dabei Katalysatoren als Reaktionsbeschleuniger. Das entstehende Polymer schreibt sich einfach als (–CH2–CH2–)n, wobei n für die Anzahl der Monomere steht. Je größer n ist, desto länger ist die Kette, was die Eigenschaften des Kunststoffs festlegt.

Ein einziges Monomer bildet ein süßlich riechendes, entzündliches Gas. Aus kurzen Ketten mit wenigen Monomeren entstehen Paraffine, also künstliche Öle und Wachse. Wachs schmilzt leicht. Je länger die PE-Molekülkette wird, desto höher steigt die Schmelztemperatur des Kunststoffs an. Und seine Festigkeit wächst: Eine Kette mit einigen tausend Monomeren eignet sich für Plastiktüten und eine mit hunderttausend Monomeren sogar für schusssichere Westen (Abb. A). PE hat also tolle Eigenschaften für viele Anwendungen. Leider ist es biologisch nicht abbaubar.

Abb. A: Die Länge der Polymerketten bestimmt die Eigenschaften des Materials. Einzelne Ethen-Moleküle bilden ein Gas, Ethen kann aus Erdgas gewonnen werden (li.). Eine Kette aus wenigen Ethen-Monomeren bildet Paraffin (Kerze in der Mitte). Das Paraffin-Molekül ist oben im Bild in einer vereinfachten Zickzack-Darstellung gezeigt, an jedem Knick sitzt ein CH2. Je länger die PE-Ketten werden, desto stabiler ist das Material, bis es sich sogar für schusssichere Westen eignet (re.). Die Zahlenwerte für n sind nur ungefähre Angaben. Links unten: Polymerisationsreaktion von n Ethen-Molekülen (li.) zu Polyethylen (PE, re.).

© R. Wengenmayr

Als Wurm mit seiner Gruppe anfing, im Rahmen des PlastX-Projekts nach Alternativen für Polyethylen zu forschen, schien das Ziel einfach zu sein. Sie kannten sich sehr gut in der Chemie der Phosphorverbindungen aus. Mit diesem Wissen sollten sie elegant bioabbaubare Kunststoffe entwickeln können. „Phosphor ist faszinierend“, meint Wurm, „zum Beispiel sorgt es für die Stabilität von DNS-Molekülen, in denen die genetische Information einer jeden Zelle steckt.“ Auf der anderen Seite kann man Phosphor in Form von Phosphatmolekülen als gezielte Schwachstellen in Polymerketten einbauen. An diesen Stellen könnten dann zum Beispiel Mikroben chemisch „knabbern“ und so allmählich die Ketten zerlegen. Der Kunststoff wäre biologisch abbaubar.

Das war der Plan, mit dem die Mainzer starteten. Doch inzwischen ist klar, dass das nicht so einfach ist. Ein Joghurtbecher etwa darf sich nicht schon im Kühlschrank zersetzen. Das verwendete Polymer muss so konstruiert sein, dass das Zersetzen erst nach der Benutzung beginnt. „Für trockene Produkte wie Mehl oder Salz ist das einfacher“, sagt der Chemiker, „für alles, was feucht oder fetthaltig ist, ist es extrem schwierig, einen funktionierenden Kunststoff zu entwickeln.“ Außerdem müssen die Polymerketten beim Abbau auch an den richtigen Stellen zerlegt werden. Es sollen ja keine kleineren Moleküle entstehen, die dann umweltschädlich sind.

Von der komplexen Herausforderung ließen sich die Mainzer aber nicht abschrecken, und tatsächlich gelangen inzwischen erste Schritte zu einem „Biopolyethylen“. Dazu synthetisieren sie im Labor zunächst ein spezielles Monomer. Dabei handelt es sich eigentlich schon um eine kurze Polymerkette, in deren Mitte eine Phosphatbrücke eingebaut ist. Das soll die zukünftige Schwachstelle sein. Nun verwenden die Forscher eine Art von Reaktion, die Alkenmetathese heißt. Alkene zeichnen sich durch mindestens eine Kohlenstoff-Doppelbindung aus; Ethen ist ein Alken. Die Alkenmetathese zerschneidet die Kohlenstoff-Doppelbindungen, platziert Alken-Stücke in den entstehenden Molekülen um und bildet neue Kohlenstoff-Doppelbindungen. Dieses chemische Vertauschungsspiel nutzen die Wissenschaftler, um ihr Polymer im Reagenzglas herzustellen (Abb. B).

Abb. B: Synthese eines Mainzer „Biopolyethylens“. Oben ist das Monomer mit dem eingebauten Phosphat in der Mitte zu sehen (P steht für Phosphor, O für Sauerstoff, R für einen Molekülrest, der hier nicht wichtig ist). Bei der Alkenmetathese werden aus vielen Monomeren lange Polymerketten (Mitte); n steht für die Anzahl der Monomere. Das nun entstandene Polymer enthält noch eine Doppelbindung. Der nächste Schritt – die sog. Hydrierung – erzeugt durch das Anbinden von Wasserstoffatomen das abbaubare Polyethylen.

© F. Wurm, MPI für Polymerforschung / CC BY-NC-SA 4.0

Im Labor zeigt Doktorand Hisaschi Tee ein kleines gläsernes Reaktorgefäß. „Dort kommt das Monomer rein, dann geben wir den Katalysator hinterher“, erklärt Wurm. Um die Alkenmetathese richtig in Schwung zu bringen, erwärmen die Chemiker den Reaktor schrittweise auf 60 bis 80 Grad Celsius. Ein Rührer durchmischt die Flüssigkeit. Der Katalysator, der die Reaktion beschleunigt, ist ein sogenannter Grubbs-Katalysator. Solche Katalysatoren haben Alkenmetathesen erst richtig erfolgreich gemacht. Benannt sind sie nach dem amerikanischen Chemiker Robert Grubbs, der dafür 2005 den Nobelpreis für Chemie erhielt.

Polymere wie Polyethylen besitzen eine weitere Eigenschaft, die im Plan der Max-Planck-Forscher eine entscheidende Rolle spielt. Ihre langen Molekülketten legen sich gerne streckenweise in gleichmäßigen Schlaufen zusammen. Sie bilden so hochgeordnete Bereiche des Polymers, die kristallin sind. Die harten „Kristallite“ sind über ungeordnete, aber miteinander verschlaufte Abschnitte verbunden. Diese Brücken zwischen den Kristalliten sind auch für die mechanischen Eigenschaften des Kunststoffs verantwortlich. In den ultralangen Ketten des besonders zähen PE-Kunststoffs für schusssichere Westen sind vor allem sie für das Stoppen einer Kugel verantwortlich. Die stabilen Kristallite verhindern den biologischen Abbau, weil Mikroorganismen sie nicht „anbeißen“ können.

Bei dem Mainzer „Biopolyethylen“ falten sich nun die Schlaufen gerade so, dass sich die Phosphate wegen ihres Platzbedarfs ganz außen auf den Kristallen anordnen (Abb. C). Dort kommen Mikroorganismen gut an diese Schwachstellen heran und können die Kristalle biochemisch anknabbern. Die Kristalle zerfallen und das Polymer zersetzt sich.

Abb. C: Elektronenmikroskopisches Bild eines Mainzer „Biopolymerkristalls“. Das kleine rechteckige Feld (li.) zeigt einen Ausschnitt aus einer elektronenmikroskopischen Aufnahme. In der Mitte ist dieser Ausschnitt vergrößert als Grafik im Schnittbild dargestellt. Man erkennt die Schlaufen des Polymers im Kristall. Außen an den Knicken sitzen die Phosphate (rotes P) als eingebaute Schwachstellen. An diesen sollen Mikroorganismen beim biologischen Abbau „knabbern“ können, sodass sich die Schlaufen auflösen (re.).

© F. Wurm, R. Wengenmayr / CC BY-NC-SA 4.0

Die ersten Versuche der Mainzer endeten bei einem eher wachsartigen Material. Die Polymerketten waren noch arg kurz. Doch inzwischen gelingen im Labor so lange Ketten, dass sich das Material zu Folien verarbeiten lässt. „Das machen wir wie beim Crêpe“, sagt Wurm: „Wir streichen es mit einem kleinen Abstreichholz aus und lassen es trocknen.“ Im Labor zeigt Hisaschi Tee, wie die Mainzer erst einmal mit Chemikalien wie Natronlauge prüfen, ob und wie die neuen Polymerfolien sich zersetzen. Das Ergebnis untersuchen sie mit Methoden, die ihnen genaue Informationen über die chemischen Strukturen der Polymerbruchstücke liefern.

Sieht das Resultat ermutigend aus, dann kommt der Test mit lebenden Organismen dran. Neben den Wasserflöhen in Frankfurt testen die Mainzer das auch selbst mit Mikroben, zum Beispiel aus Meerwasser oder Belebtschlamm aus Kläranlagen. Dazu verwenden sie spezielle Glasflaschen, sogenannte OxiTop-Systeme. Diese füllen sie mit dem Wasser oder Schlamm und geben Proben ihres neuen Kunststoffs hinzu. Dann lagern sie die Flaschen 28 Tage lang bei konstanter Temperatur. Oben auf der Flasche befindet sich ein Messkopf, der den Druck misst. Wenn die Mikroben den Kunststoff „verdauen“, dann produzieren sie Gase, und das registriert die Druckmessung. Daraus können die Chemiker errechnen, wie schnell sich der Kunststoff in einer bestimmten natürlichen Umgebung biologisch zersetzt.

Die neuen Kunststoffe aus den Mainzer Laboren werden sicher zu teuer für die Massenproduktion sein. Vor allem die Grubbs-Katalysatoren sind zu wertvoll, weil sie Ruthenium benötigen. Doch die Ergebnisse aus Mainz könnten günstige abbaubare Kunststoffe hervorbringen. Schließlich hatten die heutigen Kunststoffe auch einen schwierigen Start. Erst als Karl Ziegler, damals Direktor am Max-Planck-Institut für Kohlenforschung in Mülheim, 1953 mit seinem Team zufällig neue Katalysatoren entdeckte (nach ihren Entdeckern als Ziegler-Natta-Katalysatoren benannt), wurden Kunststoffe im großen Stil industriell herstellbar. Ziegler erhielt dafür 1963 den Nobelpreis für Chemie. Damals setzten Max-Planck-Forscher die Kunststoffe in unsere Welt. Vielleicht gelingt es heute Max-Planck-Forschern, diese revolutionäre Erfindung nachhaltiger zu machen.

Abbildungshinweise

Titelbild: Mikroplastik © Valeria Hidalgo-Ruz, GAME 2013, GEOMAR

Abb. A: Polymerketten © R. Wengenmayr

Abb. B: Synthese-Biopolymer © F. Wurm, MPI für Polymerforschung / CC BY-NC-SA 4.0

Abb. C: Biopolymer-Kristall © F. Wurm, R. Wengenmayr / CC BY-NC-SA 4.0

Der Text wird unter CC BY-NC-SA 4.0 veröffentlicht.

TECHMAX Ausgabe 25, Frühjahr 2018, Redaktion: Christina Beck, Autor: Roland Wengenmayr

© CCO

Am Abend des 5. April 1815 ist auf der indonesischen Insel Sumbawa ein lauter Knall zu hören. Kurz darauf schießt vom Gipfel des 4300 Meter hohen Vulkans Tambora ein Feuerstrahl in den Himmel. Schlammlawinen stürzen die Bergflanken hinab und begraben alles, was ihnen in den Weg kommt. Das Schlimmste aber steht noch bevor: Am 10. und 11. April sprengen mehrere gewaltige Explosionen den Gipfel in Stücke. Pyroklastische Ströme aus heißem Gas und Asche ergießen sich ins Meer, Tsunamis verwüsten die umliegenden Küsten. Gigantische Aschewolken verdunkeln den Himmel. Augenzeugen berichten von „rasenden Flammen und Wirbelwinden, die fast alle Häuser zerstörten“. Bis zum 17. April dauert das Inferno, dann endlich beruhigt sich der Berg. Als einen Tag später die „Benares“, ein Schiff der British East India Company, die Insel erreicht, stößt die Besatzung auf Tod und Verwüstung. Tausende Menschen haben durch den Ausbruch ihr Leben verloren, viele weitere sterben in den kommenden Wochen und Monaten, weil der Ascheregen die landwirtschaftliche Produktion vernichtet und das Trinkwasser vergiftet hat. Der vormals wohl höchste Vulkan des Archipels ist durch die Explosionen um fast eineinhalb Kilometer geschrumpft.

Der Rest der Welt aber sollte die Folgen des Tambora-Ausbruchs erst noch zu spüren bekommen. Denn diese Jahrtausend Eruption brachte das Klima zeitweise derart durcheinander, dass 1816 in Europa und Nordamerika als das „Jahr ohne Sommer“ in die Geschichte einging. Süddeutschland versank im Dauerregen, Ende Juli fiel sogar Schnee. Die mageren Ernten verrotteten, das Vieh verendete, oder musste aus Futtermangel geschlachtet werden. Die Getreidepreise schnellten in die Höhe. Mehl wurde mit kaum genießbaren Zutaten gestreckt und zu „Hungerbroten“ verbacken. General Carl von Clausewitz, der im Frühling 1817 durch das Rheinland ritt, schrieb: „Ich sah stark geschwächtes Volk, kaum mehr menschlich, das auf der Suche nach halb verfaulten Kartoffeln über die Äcker lief.“

In vielen Ländern forderten Hunger und Krankheiten wie die Cholera zahllose Opfer und trugen zu Migration, Unruhen und in der Folge sogar zu politischem und sozialem Wandel bei. Dabei traf das Unglück die Menschen aus dem Nichts. Eine Verbindung zu dem fernen Vulkan sahen sie nicht. Manche fingen sogar an, die Blitzableiter zu demolieren, denen sie die Schuld am schlechten Wetter gaben. Mary Shelley soll im Sommer 1816 am Genfer See ihren Roman „Frankenstein“ geschrieben haben, weil sie wegen des vielen Regens kaum vor die Tür gehen konnte. Allein in Indonesien starben durch den Tambora bis zu 100.000 Menschen. Weltweit waren es mindestens noch einmal so viele. Wie konnte es dazu kommen?

Lange Zeit war nicht einmal klar, was Vulkane überhaupt sind. Erst die Erforschung des Erdinnern im 20. Jahrhundert brachte Klarheit. Sie offenbarte, dass unter unseren Füßen gewaltige Kräfte am Werk sind. Da Temperatur und Dichte von der Erdkruste zum Erdmittelpunkt hin zunehmen, entstehen gigantische Wärme- und Materialströme. Forscher bezeichnen diese Umwälzungen als Konvektion und fanden darin erstmals eine plausible Erklärung für die Hypothese der Kontinentalverschiebung, die Alfred Wegener im Jahr 1912 formuliert hatte: Die Konvektion im Erdmantel ist die treibende Kraft dafür, dass sich die Kontinente bewegen. Sie sorgt auch dafür, dass an den mittelozeanischen Rücken ständig flüssiges Gestein aus dem Erdmantel nach oben dringt und neue Erdkruste bildet. Diese wandert in Form großer Platten wie auf einem Förderband nach beiden Seiten über den Erdmantel hinweg. Treffen zwei kontinentale Platten aufeinander, können sich Gebirge auftürmen. Die ozeanischen Platten hingegen werden spätestens nach 200 Millionen Jahren wieder vom Erdmantel verschluckt. An solchen Subduktionszonen entstehen Vulkangürtel wie der Pazifische Feuerring. In diesem besonders instabilen Bereich ereigneten sich fast alle spektakulären Ausbrüche der vergangenen Jahrhunderte, darunter die des Tambora (1815) und des Krakatau (1883), beide in Indonesien sowie der des Pinatubo (1991) auf den Philippinen.

Um die Stärke eines Ausbruchs zu messen, verwenden Geologen den Vulkanexplosivitätsindex (VEI) mit einer Skala von 0 bis 8. Die Stärke bemisst sich dabei am Volumen des ausgeworfenen pyroklastischen Materials und an der Höhe der Eruptionssäule. Eine Zunahme um eine Stufe entspricht einer zehnmal stärkeren Eruption. Der Tambora-Ausbruch von 1815 erreichte die Stärke 7. Ein solches Ereignis kommt nur alle paar tausend Jahre vor.

Wann aber verändert ein Vulkanausbruch das Klima? Und wie genau sehen die Klimaeffekte aus? Solche Fragen untersuchen Claudia Timmreck und ihre Kollegen am Hamburger Max-Planck-Institut für Meteorologie. „Vulkanausbrüche sind natürliche Klimaexperimente“, sagt die Physikerin. „Sie sind bestens geeignet, um zu untersuchen, wie sich Störungen auf die natürliche Klimavariabilität auswirken.“ Diese Variabilität zu verstehen und vom menschgemachten Klimawandel abzugrenzen, ist eine der großen Herausforderungen in der Klimaforschung.

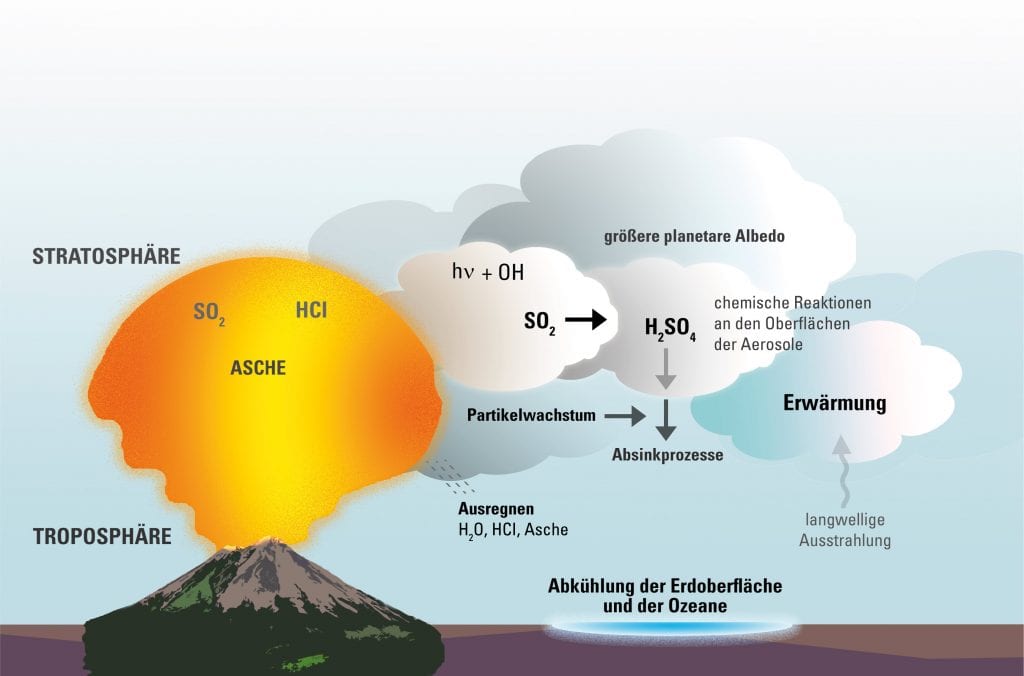

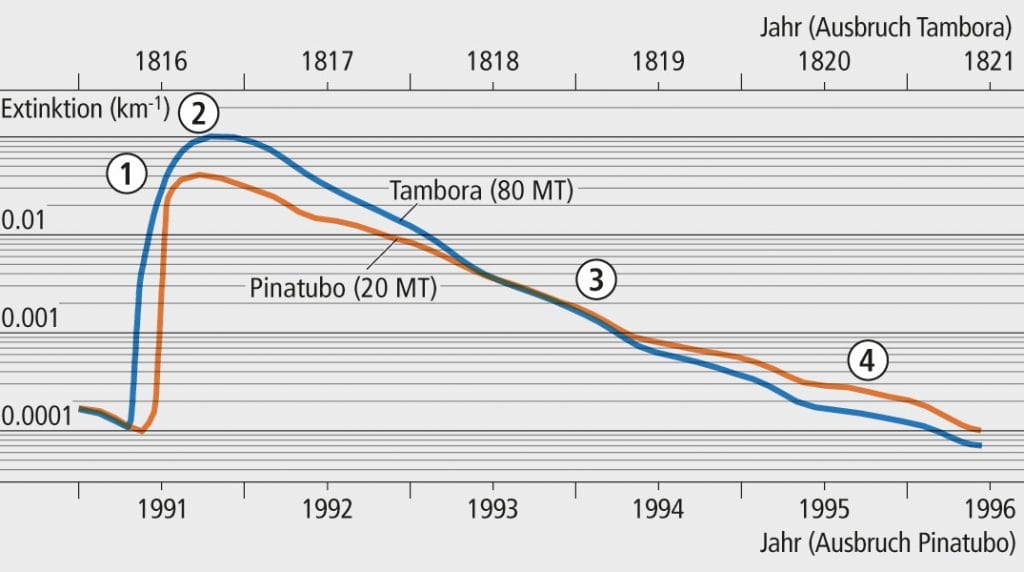

Abb. A: Klimaeffekt von großen Vulkanausbrüchen

© MPG, D. Budimlic; Quelle: MPI für Meteorologie / CC BY-NC-SA 4.0

Für die Klimaeffekte nach einem Ausbruch sind vor allem zwei Faktoren entscheidend: die Menge an freigesetztem Schwefeldioxid (SO2) und die Höhe, in welche die schwefelhaltigen Gase emporsteigen. Denn während die ausgestoßene Asche relativ schnell wieder zu Boden rieselt, wird Schwefeldioxid in der Stratosphäre fotochemisch oxidiert und verbindet sich mit Wasser zu Schwefelsäuretröpfchen (H2SO4). Solche Aerosole sorgen nicht nur für farbenprächtige Sonnenuntergänge, die nach der Tambora-Eruption Maler wie William Turner inspiriert haben. „Die Schwefelaerosole wirken wie ein künstlicher Sonnenschirm“, sagt Claudia Timmreck. „Sie streuen das einfallende Sonnenlicht in den Weltraum zurück und absorbieren zusätzlich die Wärmestrahlung der Erde. Dadurch heizt sich die Stratosphäre auf, während die bodennahen Luftschichten und die Ozeane abkühlen.“ (Abb. A)

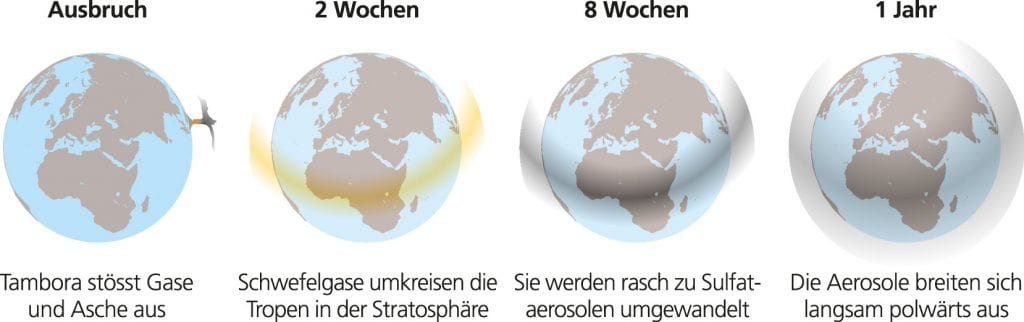

Die Höhe, in welche die Schwefelteilchen emporsteigen, hängt unter anderem von der Explosivität des Ausbruchs und den lokalen Wetterbedingungen ab, die den Auftrieb beeinflussen. Gelangen die Teilchen in eine Höhe von mehr als zwölf Kilometer und damit bis in die Stratosphäre, können sie sich als Aerosole im Verlauf mehrerer Monate über die gesamte Erdkugel verbreiten und dort mehrere Jahre lang bleiben (Abb. B). Einen globalen Einfluss haben vor allem große Vulkanausbrüche in der Nähe des Äquators, denn von dort aus können die Aerosole über die Nord- und Südhalbkugel verdriftet werden. Bei Eruptionen nahe den Polen ist dagegen nur eine Hemisphäre betroffen, und der Klimaeffekt bleibt räumlich begrenzt. Da sich die Aerosole erst allmählich ausbreiten, reagiert das Erdsystem nach einem Ausbruch zeitverzögert: „Die maximale Abkühlung ist normalerweise nach sechs bis zwölf Monaten erreicht. Danach lässt sich der Effekt noch mehrere Jahre lang nachweisen“, sagt Claudia Timmreck.

Abb. B: Ausbreitung von Schwefeldioxid und Aerosolen nach dem Ausbruch des Tambora

© aus: Brönnimann S, Krämer D, Tambora und das «Jahr ohne Sommer» 1816. Klima, Mensch und Gesellschaft. Geographica Bernensia G90

Um die Klimaeffekte von Vulkanausbrüchen besser zu verstehen, simulieren die Max-Planck-Forscher historische und neuzeitliche Ausbrüche am Computer. Ziel ist es, die Auswirkungen von künftigen Eruptionen möglichst genau vorhersagen zu können. Was würde etwa passieren, wenn es heute zu einer Eruption wie der des Pinatubo im Jahr 1991 käme? Der Ausbruch hatte die Stärke 6 und senkte damals die Erdoberflächentemperatur kurzfristig im Mittel um 0,5°C. (Zum Vergleich: Beim Tambora-Ausbruch sank die Erdoberflächentemperatur im Mittel sogar um etwa 1°C.) Das scheint nicht viel, machte sich aber wegen der großen Schwankungsbreite mancherorts deutlich bemerkbar. Die Eruption veränderte auch die Zirkulation der Atmosphäre, außerdem nahm die stratosphärische Ozonkonzentration zeitweise bis zu 50 Prozent ab. Grund dafür sind verschiedene chemische Reaktionen, die an den Oberflächen der Aerosole ablaufen und die schützende Ozonschicht zerstören. Die Pinatubo-Eruption von 1991 war die jüngste mit globalen Auswirkungen auf das Klima. Andere Ausbrüche sind dagegen zwar spektakulär, für das Klima aber nicht von Bedeutung, so wie der des isländischen Eyjafjallajökull, der im April 2010 den Flugverkehr über Europa lahmlegte. Auch die Eruptionen des Kilauea auf Hawaii und des Merapi in Indonesien, beide im Frühjahr 2018, waren nicht klimarelevant. Bei all diesen Eruptionen sind – anders als beim Tambora-Ausbruch – keine schwefelhaltigen Verbindungen in die Stratosphäre gelangt.

Um einen Vulkanausbruch am Rechner realistisch nachzustellen, müssen die Forscher ihre Computermodelle mit möglichst genauen Daten über die freigesetzte Menge an Schwefeldioxid füttern. „Heute verwenden wir dafür vor allem Satellitenmessungen“, sagt Claudia Timmreck. „Die Geräte an Bord bestimmen die sogenannte Extinktion, die angibt, wie viel Licht einer bestimmten Wellenlänge absorbiert wird. Daraus lassen sich Menge und Größe der Partikel errechnen. Daten zur Größenverteilung der Teilchen bekommen wir auch von Forschungsballons.“

Wenn es um Eruptionen in der Vergangenheit geht, ist dagegen Detektivarbeit gefragt: Dafür arbeiten Wissenschaftler unterschiedlicher Disziplinen zusammen, darunter Meteorologen, Geologen und Botaniker. Die Klimaentwicklung vergangener Epochen lässt sich aus Baumringen ablesen: Sie dokumentieren etwa, wenn das Wachstum durch einen extrem kalten Sommer beeinträchtigt war. Die Schwefeldioxid-Mengen bestimmen die Forscher anhand von Eisbohrkernen aus der Arktis und Antarktis. Aus den darin enthaltenen Konzentrationen der Wasserisotope lassen sich die Temperaturen früherer Epochen rekonstruieren; die im Eis eingeschlossene Luft gibt Auskunft über die Zusammensetzung der Atmosphäre. All diese Informationen sind praktischerweise in zeitlicher Reihenfolge archiviert: Je weiter die Klima-Chronisten in die Tiefe bohren, desto ferner reisen sie in die Vergangenheit, aber desto unsicherer und ungenauer werden auch ihre Daten.

Bei ihren Auswertungen müssen die Forscher berücksichtigen, dass etwa nach einem Ausbruch in den Tropen nur ein bestimmter Prozentsatz an Schwefeldioxid an den Polen ankommt. „Wie viel das ist, können wir anhand des Fallouts bei Atomtests in den 1960er-Jahren abschätzen“, sagt Claudia Timmreck. Um die lokale Variation herauszurechnen, analysieren die Wissenschaftler stets mehrere Bohrkerne von unterschiedlichen Orten.

Die Hamburger Max-Planck-Forscher erhalten von ihren Kollegen immer wieder neue Daten, mit denen sie ihre Modelle unterfüttern und erweitern. Indem sie verschiedene Parameter wie lokale Wetterbedingungen und Luftströmungen oder globale Zirkulationsanomalien wie El Niño variieren und die Ergebnisse mit Beobachtungen vergleichen, gelangen sie zu immer realistischeren Einschätzungen, welchen Klimaeinfluss Vulkane haben. Für ihre sehr aufwendigen Simulationen verwenden die Forscher den Hochleistungsrechner des Deutschen Klimarechenzentrums (DKRZ). „Aus der Menge an Schwefeldioxid, die anhand von Eisbohrkernen bestimmt wurde, lassen sich mithilfe von numerischen Modellen die globale Ausbreitung und Lebensdauer der vulkanischen Wolke und der damit verbundene vulkanische Strahlungsantrieb ermitteln“, so Timmreck. Der Wert ist ein Maß dafür, wie klimawirksame Faktoren – etwa Schwefelaerosole oder Treibhausgase – die Energiebilanz der Erde und der Atmosphäre verändern, indem sie das Gleichgewicht zwischen einfallender Sonnenstrahlung und von der Erde reflektierter Wärmestrahlung verschieben. Der Strahlungsantrieb wird in Watt pro Quadratmeter (W/m2) angegeben. Um den menschgemachten Klimawandel zu bremsen (siehe Geomax 18), wäre ein einzelner Vulkanausbruch übrigens längst nicht genug: „Dazu bräuchte man fünf bis sieben Pinatubos – pro Jahr!“ sagt Claudia Timmreck. Wenn aber schon ein „normaler“ Vulkan das Weltklima beeinflussen kann – welchen Effekt hat dann erst der Ausbruch eines Supervulkans mit der Stärke 8, wie er sich vor rund 640.000 Jahren im Yellowstone-Gebiet im US-Bundesstaat Wyoming ereignete? Supereruptionen sind extrem große Vulkanausbrüche, die mehr als 1000 Milliarden Tonnen Material ausstoßen – rund 150 Mal so viel wie der Pinatubo im Jahr 1991. Die Yellowstone-Eruption bedeckte damals große Teile des Kontinents mit einer zehn Zentimeter dicken Ascheschicht „Bei großen Eruptionen, die sehr viel Schwefeldioxid freisetzen, kommt noch ein anderer Faktor hinzu“, sagt Claudia Timmreck: „Die Schwefelteilchen verklumpen und verändern dadurch ihre Strahlungseigenschaften. Größere Teilchen sind außerdem schwerer und fallen schneller aus der Atmosphäre aus.“ Das bedeutet, dass der Klimaeffekt von großen Eruptionen nicht proportional zur Menge an freigesetztem Schwefeldioxid ansteigt. Frühere Modelle haben das jedoch nicht berücksichtigt und den Strahlungsantrieb meist überschätzt (Abb. C).

Abb. C: Wirkung vulkanischer Aerosole. Oben: Anzahl und Wachstum von Aerosolpartikeln nach den Ausbrüchen von Pinatubo und Tambora. Unten: Vergleich der Aerosolextinktion (= die Wirkung auf die kurzwellige Strahlung), basierend auf Modellsimulationen. Die Grafik zeigt die Verhältnisse am Äquator in 20 Kilometern Höhe. Die Beziehung zwischen der stratosphärischen Sulfatmenge und der Reduktion der kurzwelligen Strahlung ist nicht linear. Eine große Eruption wie die des Tambora hat daher keine proportional größere Wirkung als eine kleinere Eruption wie die des Pinatubo. Der Grund dafür liegt im Wachstum der Aerosolpartikel (oben).

© aus: Brönnimann S, Krämer D, Tambora und das «Jahr ohne Sommer» 1816. Klima, Mensch und Gesellschaft. Geographica Bernensia G90

Vor diesem Hintergrund dürfte auch der Ausbruch des indonesischen Vulkans Toba vor 74.000 Jahren weniger dramatische Folgen gehabt haben als bisher angenommen. Nach der sogenannten Toba-Katastrophentheorie soll durch die Eruption ein Großteil der damals lebenden Menschenpopulation umgekommen sein. Den „genetischen Flaschenhals“, also die begrenzte genetische Variabilität unter den heutigen Menschen, kann der Ausbruch dennoch nicht verursacht haben. Die Hamburger Klimaforscher haben bei ihren Simulationen für den Toba die hundertfache Schwefelmenge des Pinatubo-Ausbruchs zugrunde gelegt. Heraus kam eine maximale globale Abkühlung von 3,5°C. Zu wenig, um den Fortbestand von – auch wenn es in den Jahren nach dem Ausbruch in vielen Gegenden der Welt ziemlich ungemütlich gewesen sein dürfte.

Abbildungshinweise:

Titelbild: Aschewolke © CCO

Abb. A: Klimaeffekt Vulkanausbruch © MPG, D. Budimlic; Quelle: MPI für Meteorologie / CC BY-NC-SA 4.0

Abb. B: Aerosole Tambora © aus: Brönnimann S, Krämer D, Tambora und das «Jahr ohne Sommer» 1816. Klima, Mensch und Gesellschaft. Geographica Bernensia G90

Abb. C : Wirkung Aerosole © aus: Brönnimann S, Krämer D, Tambora und das «Jahr ohne Sommer» 1816. Klima, Mensch und Gesellschaft. Geographica Bernensia G90

Der Text wird unter CC BY-NC-SA 4.0 veröffentlicht.

GEOMAX Ausgabe 23, Sommer 2018; Autorin: Elke Maier; Redaktion: Christina Beck

© ESO / M. Kornmesser

Cerro Paranal, 2635 Meter über Meereshöhe. Der Raum liegt im Halbdunkel. Auf den Bildschirmen flimmern Zahlen und Kurven. Ähnlich Piloten in der Kanzel einer Düsenmaschine tauschen die Menschen vor den Monitoren routiniert Informationen aus, raunen sich gelegentlich Nummern oder Buchstabenkürzel zu. Draußen spähen unterdessen vier gigantische Spiegelteleskope zum Himmel über den chilenischen Anden. Seit Stunden überträgt eines der Fernrohre Bilder aus dem Herzen der Milchstraße auf den Beobachtungsmonitor. Weit nach Mitternacht ein Ausruf des Erstaunens: „Was macht der denn da!“ Ein Lichtpunkt war aus dem Nichts aufgetaucht und wenig später spurlos verschwunden. Was hat das zu bedeuten? Bald steht fest: Die Wissenschaftler haben das schwarze Loch im Zentrum der Milchstraße bei einer Mahlzeit ertappt.

Der Beginn eines Science-Fiction-Films? Nein, die Szene ist Realität. Abgespielt hat sie sich im Kontrollraum des Very Large Telescope (VLT) der Europäischen Südsternwarte. Die Protagonisten: ein internationales Team von Astronomen um Reinhard Genzel vom Max-Planck-Institut für extraterrestrische Physik in Garching und – ein schwarzes Loch. Was verbirgt sich hinter einem solchen Massemonster?

Schon der britische Naturforscher John Mitchell spekulierte 1783 über „dunkle Sterne“. Ein paar Jahre später vermutete der französische Mathematiker Pierre-Simon Laplace, dass diese Objekte tatsächlich existieren. In Gedanken ließ er eine Materiekugel bei gleichbleibender Masse so lange schrumpfen, bis die Gravitationsbeschleunigung an ihrer Oberfläche so stark anwuchs, dass die Fluchtgeschwindigkeit den Wert der Lichtgeschwindigkeit erreichte. Unter diesen Verhältnissen entkommen nicht einmal mehr Photonen den Schwerkraftfesseln des Körpers: Er wird für den Betrachter unsichtbar, gleichsam zum schwarzen Loch.

Der Astronom Karl Schwarzschild berechnete Anfang des 20. Jahrhunderts mithilfe der kurz zuvor von Albert Einstein vorgestellten allgemeinen Relativitätstheorie als Erster den Radius einer Kugel, die das oben genannte Kriterium erfüllt, auf deren Oberfläche also die Fluchtgeschwindigkeit gleich der Lichtgeschwindigkeit (ungefähr 300.000 Kilometer pro Sekunde) ist. Die Erde etwa müsste man dazu auf die Größe einer Erbse zusammenquetschen, ihr Schwarzschildradius beträgt knapp einen Zentimeter! Die Überlegungen von Laplace und die Berechnungen von Schwarzschild blieben zunächst theoretisch. Erst als die Wissenschaftler in den 1930er-Jahren die Physik der Sterne zu verstehen begannen, rückten die schwarzen Löcher allmählich ins Blickfeld.

Um einen solchen kosmischen Exoten hervorzubringen, braucht es einen Stern mit mehr als der achtfachen Masse unserer Sonne. Am Ende seines Lebens angekommen, verbrennt der Gasgigant in mehreren übereinanderliegenden Schalen chemische Stoffe. Im Zentrum dieser „Zwiebel“ produziert der Fusionsreaktor bei Temperaturen von einer Milliarde Grad zunehmend komplexere Elemente wie Sauerstoff und Silizium. Kurz vor dem Sternentod geht es immer schneller: Innerhalb von wenigen Monaten und später nur mehr einigen Tagen werden Nickel, Kobalt und schließlich Eisen erzeugt.

Damit ist das Ende erreicht: Weil Eisen die höchste Bindungsenergie pro Kernbaustein besitzt, lässt sich aus seiner Fusion keine Energie mehr gewinnen. Der stellare Ofen erlischt, was die Gaskugel aus dem Gleichgewicht bringt. Das Wechselspiel zwischen dem Druck der Sternmaterie, der nach außen wirkt, und dem nach innen gerichteten Gravitationsdruck wird empfindlich gestört. Der Kern des Sterns bricht unter seinem eigenen Gewicht in sich zusammen. Die äußere Hülle dagegen schießt ins All und leuchtet als Supernova hell auf.

Gleichzeitig erreicht die Dichte im Zentrum des Sterns astronomisch hohe Werte. Dies führt dazu, dass elektrisch negativ geladene Elektronen in die elektrisch positiv geladenen Protonen gequetscht werden und Neutronen bilden. Auf diese Weise formt sich eine Kugel mit ungefähr 20 Kilometern Durchmesser und der Masse unserer Sonne – ein Neutronenstern. Auf der Erde würde ein Teelöffel seiner Materie einige Milliarden Tonnen wiegen. Weil der Drehimpuls, das Produkt aus Trägheitsmoment und Winkelgeschwindigkeit, nicht verloren geht, beschleunigt sich die eher gemächliche Rotation des vormals gesunden Sterns in dem Maße, wie sich sein kollabierter Kern verdichtet und schrumpft. Wegen der immensen Fliehkräfte verlassen ständig Teilchen die Oberfläche, werden in dem starken Magnetfeld beschleunigt und senden in zwei gebündelten Strahlungskegeln sogenannte Synchrotronstrahlung aus. Überstreicht dieser kosmische Leuchtturm die Erde, scheint der Stern im Millisekundentakt zu blinken, man spricht von einem Pulsar.

Es geht aber noch dichter. Wenn die kollabierte Restmasse des gestorbenen Sterns etwa drei Sonnenmassen überschreitet, dann zieht sich die ausgebrannte Kugel völlig in sich zusammen – bis das exotische Gebilde schließlich die Größe des doppelten Schwarzschildradius erreicht. Bei diesem Prozess gehen alle Strukturen verloren, ein schwarzes Loch entsteht. Lediglich drei Parameter charakterisieren ein solches Objekt: Masse, Drehimpuls und elektrische Ladung.

Ähnlich einem Schlafenden, der eine weiche Matratze eindellt, krümmen nach Einsteins allgemeiner Relativitätstheorie Massen den Raum. Die extrem starken Gravitationsfelder eines schwarzen Lochs sollten den Raum so verbiegen, dass er sich trichterförmig abkapselt. Karl Schwarzschild selbst hat die Struktur des Raums um ein ruhendes schwarzes Loch beschrieben – das es in der Natur wegen der Erhaltung des Drehimpulses wohl gar nicht gibt. Ein Teil des Drehimpulses wird zwar in Form von Gravitationswellen abgestrahlt (siehe auch TECHMAX 4), gleichwohl sollte das schwarze Loch rotieren. Erst in den 1960er-Jahren gelang es den Theoretikern, allen voran dem neuseeländischen Mathematiker Roy Kerr, die Metrik eines solchen Objekts in Formeln zu fassen.

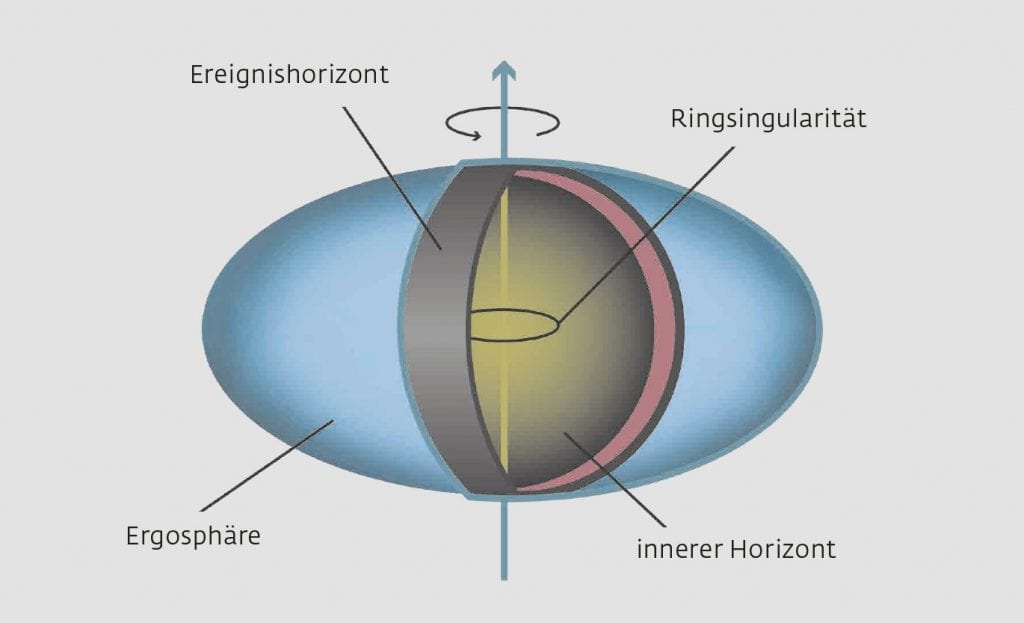

Wie also sieht ein schwarzes Loch aus? Vereinfacht gesagt, liegt ganz außen eine abgeplattete Kugelfläche, die Ergosphäre. Sie umschließt den kugelförmigen Ereignishorizont, gleichsam die Grenzfläche des schwarzen Lochs. Was sich jenseits von ihm abspielt, ist von außen unzugänglich. Weiter innen liegt der innere Horizont, auch Cauchy-Horizont genannt. Im Zentrum sitzt die Singularität, die sich mit den Gesetzen unserer Physik nicht beschreiben lässt. Bei einem schwarzen Loch, wie es Roy Kerr durchgerechnet hat, ist das eine Ringsingularität – aber ohne Ausdehnung und mit dem Radius null! So ein Konstrukt kann man sich beim besten Willen nicht vorstellen (Abb. A). Einfacher ist das mit dem Schicksal von Gasteilchen, die mit langsamer Geschwindigkeit die oben genannte Ergosphäre überschreiten. Sie landen dann auf spiralförmigen Bahnen und ziehen immer engere Kreise. Die Gravitationsenergie wächst, während das schwarze Loch seinerseits Drehimpuls einbüßt. Fällt also Gas auf ein schwarzes Loch, heizt es sich durch diesen Mechanismus sehr stark auf. Am heißesten wird die Materie auf der letzten stabilen Umlaufbahn (last stable orbit), wo Temperaturen um die 100 Milliarden Grad Celsius auftreten. Doch dort verharrt das Gas nicht lange, nach etwa einer halben Stunde wilder Fahrt verschwindet es hinter dem Ereignishorizont.

Abb. A: Hinter dem Horizont

Die Grafik zeigt ein rotierendes schwarzes Loch. Die Ergosphäre bezeichnet jenen Bereich, in dem jedes beliebige Objekt mitrotieren muss. Der Ereignishorizont ist so etwas wie die Oberfläche des schwarzen Lochs; was dahinter verschwindet, ist im wahrsten Sinne aus der Welt.

© designergold nach einer Vorlage des MPI für Gravitationsphysik

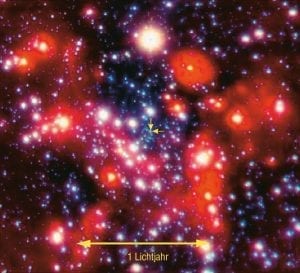

Genau das haben die Astronomen im Kontrollraum des Very Large Telescope auf dem Andengipfel Cerro Paranal live verfolgt! Aus gutem Grund beobachteten die Forscher das Herz unserer Galaxis (Abb. B). Denn darin hatte eine Gruppe um Reinhard Genzel, Direktor am Garchinger Max-Planck-Institut für extraterrestrische Physik, in den 1990er-Jahren ein gigantisches schwarzes Loch entdeckt. Es besitzt ungefähr vier Millionen Sonnenmassen und kann nicht durch eine einzige Supernova entstanden sein. Daher sprechen die Forscher nicht von einem stellaren, sondern von einem supermassiven schwarzen Loch. Nach der lateinischen Bezeichnung des Sternbilds Schütze, in dem der Mittelpunkt des Milchstraßensystems von der Erde aus gesehen liegt, heißt das Objekt „Sagittarius A Stern“ (SgrA*). Es sitzt innerhalb eines dichten Sternhaufens mit einer sehr kompakten, ungewöhnlich hellen zentralen Radioquelle. Deren Durchmesser beträgt weniger als 300 Millionen Kilometer und ist damit kleiner als der Durchmesser der Erdbahn um die Sonne.

Abb. B: Zoom ins Zentrum

Mit einer Infrarotkamera am Very Large Telescope in Chile blicken Astronomen ins Herz der Milchstraße. Die beiden gelben Pfeile in der Mitte markieren die Position der Radioquelle SgrA*.

© MPI für extraterrestrische Physik

Doch handelt es sich bei SgrA* wirklich um ein schwarzes Loch? Angesichts der hohen Masse auf engem Raum erscheint dies als sehr wahrscheinlich. „Aber zwischen Plausibilität und physikalischer Sicherheit gibt es doch einen Unterschied“, sagt Reinhard Genzel. „Daher denken wir uns alle möglichen Tests aus. Das galaktische Zentrum bietet hier fantastische Möglichkeiten.“ War die eingangs beschriebene Live-Beobachtung – also das Verschlucken von Materie – vor ein paar Jahren eher Zufall, so haben die Astronomen in den vergangenen Monaten gezielt nach einem solchen Prozess gesucht. Und kürzlich sind sie fündig geworden!

Geholfen haben ihnen dabei wiederum das Very Large Telescope und ein sehr komplexes Instrument namens Gravity. Mit ihm nutzen die Forscher alle vier Acht-Meter-Spiegel des VLT gleichzeitig. Dieses Verfahren heißt Interferometrie. Bei ihm werden die Wellen ein und desselben Objekts aus den vier Einzelteleskopen überlagert, wodurch dieses im Ergebnis schärfer erscheint. In der Radioastronomie ist die Methode schon seit Jahrzehnten etabliert, im optischen Licht dagegen nicht. Daher hat das Max-Planck-Institut für extraterrestrische Physik unter Leitung von Frank Eisenhauer zusammen mit dem Max-Planck-institut für Astronomie, der Europäischen Südsternwarte, der Universität Köln, zwei französischen CNRS-Instituten sowie Instituten in Porto und Lissabon Gravity entwickelt. Dieses Instrument verarbeitet die Signale der vier Einzelteleskope und verbessert im Infrarotbereich die Detailauflösung enorm. Das heißt, das VLT könnte dank Gravity zwei nebeneinanderliegende Zwei-Euro-Münzen auf dem Mond sichtbar machen.

Mit Gravity haben die Astronomen um Reinhard Genzel gleichsam den Rand des vermeintlichen schwarzen Lochs ins Visier genommen. Der Theorie nach müssten die Elektronen des Gases, das sich dem Ereignishorizont nähert, beschleunigt werden und dadurch die Helligkeit zunehmen. In der nur wenige Lichtstunden kleinen Region um das schwarze Loch herrschen chaotische Verhältnisse ähnlich wie in irdischen Gewittern oder Strahlungsausbrüchen auf der Sonne. Dabei spielen auch noch starke Magnetfelder eine Rolle, denn das Gas ist elektrisch leitend, also ein Plasma. Dieses sollte sich schließlich als flackernder heißer Fleck zeigen, der das schwarze Loch auf der letzten stabilen Bahn umkreist. Tatsächlich: Dank Gravity sahen die Forscher gleich drei solcher Flares, hot spots genannt. „Alle hatten sie dieselben Radien und dieselben Umlaufperioden“, sagt Genzel. Wie erwartet, war das Gas nach 30 Minuten verschwunden, gleichsam verschluckt vom schwarzen Loch. Nicht nur bedeutet diese Beobachtung ein ziemlich starkes Indiz für die Existenz des dunklen Massemonsters im Herzen der Galaxis. Zudem können die Forscher anhand derartiger Messungen entscheiden, ob es sich um ein ruhendes Schwarzschild-Loch oder ein rotierendes Kerr-Loch handelt. Die bisher gesammelten Hinweise sprechen für Letzteres.

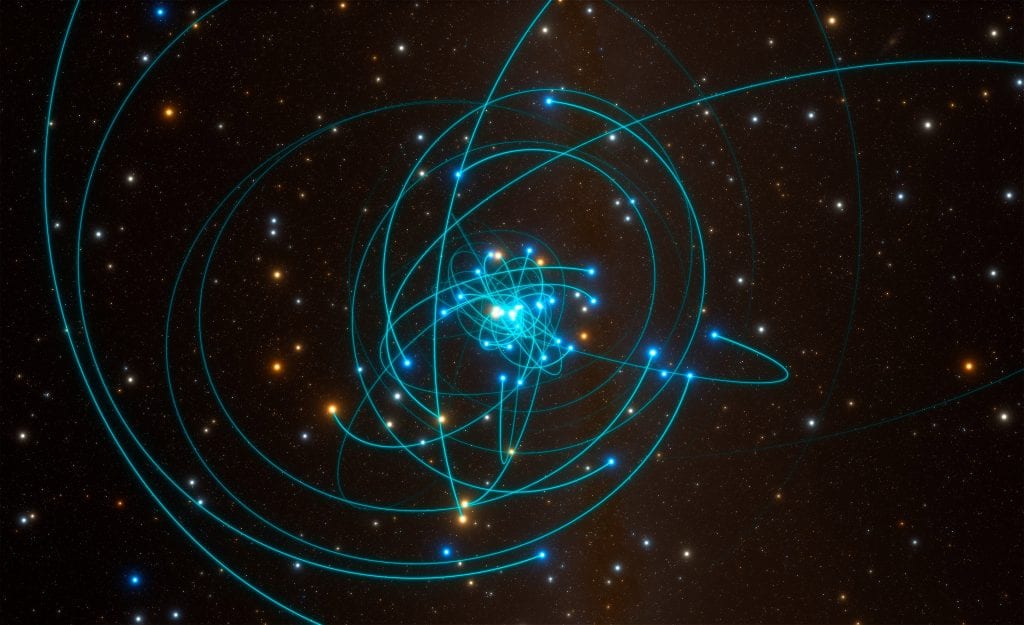

Tief im galaktischen Zentrum warten noch mehr spannende Entdeckungen auf die Astronomen. Diese haben schon vor einigen Jahren damit begonnen, die weitere Umgebung des schwarzen Lochs zu studieren. Denn dort ziehen jede Menge Sterne ihre Bahnen (Abb. C). Aus dem Vergleich von mehreren, zu unterschiedlichen Zeitpunkten gewonnenen scharfen Aufnahmen mit neuen Beobachtungstechniken bestimmten die Forscher die Eigenbewegungen der Sterne sowie mittels des Dopplereffekts deren Radialgeschwindigkeiten. Diesen Effekt kennen wir aus dem Alltag, wenn etwa ein Rettungswagen an uns vorbeifährt und die Tonhöhe des Martinshorns an- und abschwillt. Das bedeutet gleichzeitig eine Verschiebung der Wellenlänge in den kurz- beziehungsweise langwelligen Bereich. Dies gibt es auch bei Lichtwellen, wobei man dann von Blau- oder Rotverschiebung spricht.

Abb. C: Galaktischer Bienenschwarm

Die Simulation zeigt die Sternenbahnen nahe dem supermassereichen schwarzen Loch im Herzen der Milchstraße.

© ESO/ L. Calçada/spaceengine.org

Die erwähnte Eigenbewegung bezeichnet die Winkelgeschwindigkeit am Himmel, die Radialgeschwindigkeit das Tempo entlang der Sichtlinie zur Erde. Die Analyse beider Komponenten ergab die wahren Bewegungen der Sterne im Raum. Als „Star“ auf den Fotos entpuppte sich S2: Der Stern nähert sich der Radioquelle SgrA* bis auf etwa 17 Lichtstunden oder die dreifache Distanz zwischen Sonne und Neptun. S2 läuft auf seiner hochelliptischen Keplerbahn und wird dabei bis zu 25 Millionen Kilometer pro Stunde schnell. Für die Umrundung des schwarzen Lochs benötigt er etwa 15 Jahre.

Im Mai 2018 sollte S2 wieder einmal in der geringsten Entfernung von 14 Milliarden Kilometern am Massemonster vorbeiziehen – eine perfekte Gelegenheit, um in dieser Region mit der stärksten Schwerkraft unserer Galaxis die allgemeine Relativitätstheorie zu testen. Wieder lagen die Astronomen mit dem Instrument Gravity auf der Lauer. Und erneut gelang eine bemerkenswerte Beobachtung: Der Stern zeigte eine Rotverschiebung, die nicht vom Dopplereffekt herrührt. Denn unabhängig von ihm sollte nach Einsteins Theorie auch im Schwerefeld eine Rotverschiebung auftreten, wenn sich Licht dort bewegt und gewissermaßen dagegen ankämpft. Diesem Effekt unterlag die Strahlung des Sterns S2: Die Forscher registrierten genau diese Gravitations-Rotverschiebung (Titelbild).

Das schwarze Loch in der Milchstraße ist aber nicht nur ein „Freilandlabor“ für die Physik der Schwerkraft, sondern ein Modellfall: Offensichtlich verbergen sich auch in den Zentren der meisten anderen Spiralgalaxien mit stellarem Kernbereich sowie in elliptischen Galaxien solche schwarzen Löcher. Dabei gilt: Je massereicher der Kern, desto massereicher das schwarze Loch. Diese enge Korrelation deutet auf eine gemeinsame Genese hin. Doch über die Geburten der Galaxien rätseln die Forscher noch, ebenso über die Entwicklung einer Schwerkraftfalle mit einigen Millionen oder gar Milliarden Sonnenmassen. Ein Szenario sieht so aus: Schon wenige 100 Millionen Jahre nach dem Urknall existierten Sterngiganten mit bis zu 1000 Sonnenmassen. Sie explodierten als Meganovae und hinterließen entsprechend massereiche schwarze Löcher. Diese sammelten sich in Energiemulden, verschmolzen miteinander und legten durch das Verschlucken von Gas weiter an Gewicht zu, wuchsen also zu supermassiven schwarzen Löchern heran.

Bis vor wenigen Jahren dachten die Wissenschaftler, es gebe im Wesentlichen nur zwei Klassen von schwarzen Löchern: stellare und supermassereiche. Dann wurden am 14. September 2015 Gravitationswellen entdeckt, die offenbar aus der Kollision von zwei schwarzen Löchern mit 29 und 36 Sonnenmassen stammten. Deren Entstehung liegt ebenso im Dunkeln wie die von schwarzen Löchern mit einigen Hundert oder Tausend Sonnenmassen, welche die Forscher im All ebenfalls gefunden haben wollen. Nicht zuletzt mit der Entdeckung von Gravitationswellen und den Messungen im Herzen der Milchstraße hat die Ära der Beobachtung schwarzer Löcher begonnen. Die Astronomen im Kontrollraum auf dem Paranal haben wohl noch manche aufregende Nacht vor sich …

Bis zum Horizont

Exkurs: © EHT-Kollaboration

Ein schwarzes Loch direkt beobachten? Das klingt nach Fiction, doch daraus wurde Science. Ermöglicht hat es ein Radioobservatorium der Superlative. Dieses Event Horizon Telescope (EHT) besteht aus mehreren, über den halben Globus verteilten Stationen. Es arbeitet nach dem Prinzip der Very Long Baseline Interferometry (VLBI): Dabei werden die einzelnen Antennen zusammengeschaltet und zu einem virtuellen Riesenteleskop von der Größe unseres Planeten vereint. Die Anlage empfängt Strahlung im Millimeterbereich des elektromagnetischen Spektrums und liefert eine Winkelauflösung, die einen Tennisball auf dem Mond zeigen würde. Bei einer Beobachtungskampagne im April 2017 nahmen die Forschenden des EHT unter anderem das rund 55 Millionen Lichtjahre entfernte Milchstraßensystem Messier 87 ins Visier – und präsentierten zwei Jahre später eine Sensation: Das am Computer rekonstruierte Bild des schwarzen Lochs im Zentrum dieser elliptischen Riesengalaxie. Dabei registrierte das EHT jene Lichtteilchen, die um Haaresbreite den Fängen dieser gigantischen Schwerkraftfalle im Herzen von M 87 entkommen waren.

Abbildungshinweise:

Titelbild: Schwarzes Loch © ESO, M. Kornmesser

Abb. A: Schwarzes Loch-rotierend © designergold nach einer Vorlage des MPI für Gravitationsphysik

Abb. B: Milchstrasse © MPI für extraterrestrische Physik

Abb. C: Sternenbahnen © ESO; L. Calçada; spaceengine.org

Exkurs: © EHT-Kollaboration

Der Text wird unter CC BY-NC-SA 4.0 veröffentlicht.

TECHMAX Ausgabe 26, Herbst 2018; Online-Text aktualisiert 04/2020; Autor: Helmut Hornung; Redaktion: Christina Beck