Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

YouTube-Link: https://youtu.be/QRp8bKS81Ag

Jasmonsäure ist ein wichtiger Bestandteil der Pflanzensprache. Diese Substanz signalisiert der Tabakpflanze, dass sie von Schädlingen attackiert wird. Forscher am Max-Planck-Institut für chemische Ökologie in Jena untersuchen die Verteidigungsstrategien der Pflanzen, um so eines Tages Kulturpflanzen züchten zu können, die keine Insektenvernichtungsmittel mehr zum Schutz benötigen. Mehr Infos: www.ice.mpg.de

[Dauer des Videos: 4 min]

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

YouTube-Link: https://youtu.be/52TOK4NWETQ

Wilde Tabakpflanzen sind von vielen Feinden umgeben, die ihnen sozusagen an die Blätter wollen. Der unangenehmste von ihnen ist der Tabakschwärmer (Manduca sexta). Dabei ist der Falter auch überlebenswichtig für die Pflanze: Er bestäubt nämlich die Blüten. Wissenschaftler vom Max-Planck-Instittut für chemische Ökologie in Jena untersuchen in den trockenen Gebieten von Utah, USA, wie sich die Tabakpflanzen gegen den Tabakschwärmer wehren. Sie nutzen dabei Verstärkung: Räuberische Wanzen. Weitere Infos: www.ice.mpg.de

[Dauer des Videos: 6 min]

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

YouTube-Link: https://youtu.be/kzfupX-QGP4

Ian Baldwin vom Max-Planck-Institut für chemische Ökologie in Jena erforscht, welche Strategien Pflanzen entwickeln, um sich gegen Schädlinge zu wehren. Die Tabakpflanze z.B. bildet den Signalstoff Jasmonsäure, wenn sie von Heuschrecken angeknabbert wird. So aktiviert sie Abwehrsystem gegen die Freßschädlinge. Mehr Infos: www.ice.mpg.de/ext/molecular-ecology.html?&L=1

[Dauer des Videos: 5 min]

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

YouTube-Link: https://youtu.be/5t7xgr_sg98

Am Max-Planck-Institut für Polymerforschung in Mainz will Eva-Katrin Sinner eine künstliche Nase entwickeln, die nicht nach den Prinzipien der Physik funktioniert, sondern nach dem biologischen Vorbild der Natur. Dabei lässt sie sich von den Riechsinneszellen echter Nasen inspirieren. Die Biologieprofessorin erforscht, was beim Riechen auf der Skala einzelner Moleküle an den Membranhüllen der Nervenzellen geschieht. Das will sie mit künstlichen Zellmembranen nachahmen. Erste Erfolge kann sie schon vorweisen, wofür sie 2007 einen Forschungspreis erhielt. Ihre Strategie, die Tricks der Evolution technisch nachzuahmen, nennt sich Biomimetik.

[Dauer des Videos: 7 min]

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

YouTube-Link: https://youtu.be/tSGLYQ_6s-Q

Gerüche lösen starke Emotionen in uns aus: Angst und Freude, Ekel und Verlangen, Abscheu und Zuneigung. Es mag Gerüche geben, die von Natur aus abstoßend wirken (beispielsweise der Gestank von verrottendem Fleisch), die meisten Gerüche jedoch bewerten wir je nach persönlicher Erfahrung und kulturellem Hintergrund, und mit vielen Gerüchen verbinden wir Erinnerungen, die unsere Wahrnehmung und Bewertung des Geruchs beeinflussen. Mit Hilfe unserer Nase können wir Tausende von Gerüchen unterscheiden. Die Riechzellen, sie heißen auch „olfaktorische Sinneszellen“, werden über Gerüche aktiviert. Fast alle dieser Nervenzellen befinden sich in einem kleinen Bereich im Dach der Nasenhaupthöhle, im Riech-Epithel. Hier sitzen Millionen von Riechzellen. Die Signale werden von dort über den Riechnerv direkt an das Gehirn weitergeleitet.

[Dauer des Videos: 3 min]

Datenschutzhinweis: Mit dem Klick auf den Play-Button starten Sie ein YouTube-Video. Vorher werden keine Daten an YouTube übertragen.

Im Jahr 1889 ist der französische Romanautor Jules Verne wieder einmal seiner Zeit voraus. In seinem Buch „Der Schuss am Kilimandscharo“ planen seine Protagonisten, die Erdachse gerade zu rücken und damit die Jahreszeiten abzuschaffen. Das eigentliche Ziel ist jedoch eine Veränderung des Klimas: Schmilzt durch die Erd- und Klimakorrekturen das Eis der Arktis, kann man die in der Region vermuteten riesigen Kohlevorräte abbauen. Bewerkstelligt werden soll dies alles durch einen einzigen Schuss mit einer Riesenkanone. Der gewaltige Rückstoß, so haben die Berechnungen der Abenteurer ergeben, würde für die gewünschte Wirkung sorgen. Dass dadurch auch dramatische Änderungen des Meeresspiegels und verheerende Überschwemmungen auftreten könnten, nehmen sie billigend in Kauf. Trotz massiver Proteste in der Öffentlichkeit wird das Projektil abgefeuert. Aber der Plan scheitert, die Erdachse bleibt wie sie ist.

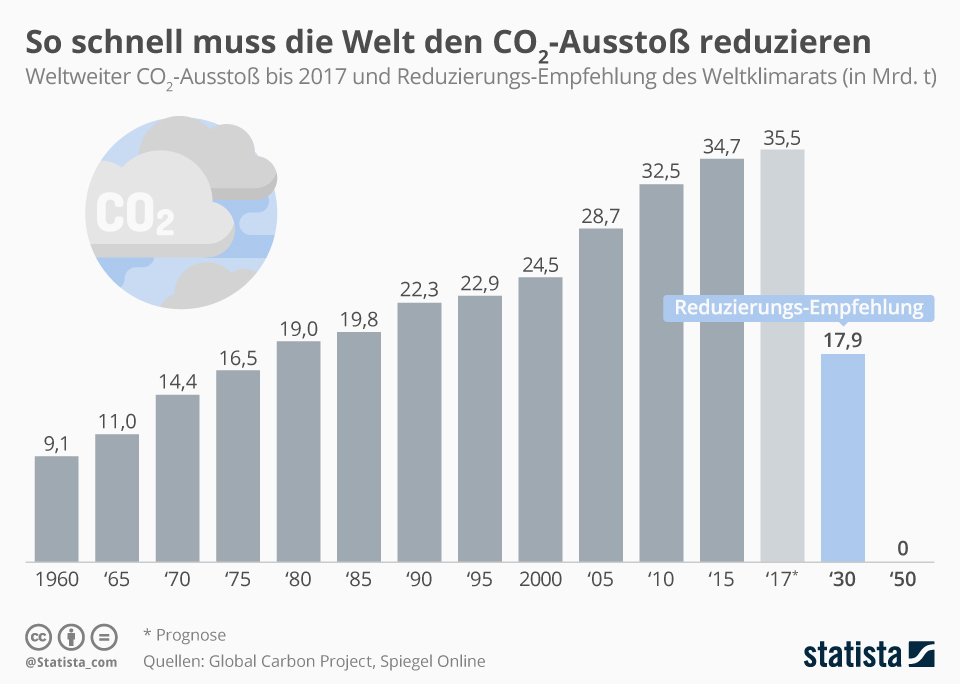

Waren technische Eingriffe in das Klima unseres Planeten zu Zeiten von Jules Verne noch reine literarische Gedankenspiele, so werden sie heute tatsächlich wissenschaftlich geplant und erprobt – bisher allerdings im kleinen Maßstab. Dass sich Politiker und Wissenschaftler überhaupt ernsthaft Gedanken zu diesem Thema machen, hat vor allem einen Grund: den fortschreitenden Klimawandel. Prognosen gehen davon aus, dass die global gemittelten Temperaturen bis Ende des 21. Jahrhunderts je nach Szenario um bis zu 5,4 °C steigen könnten – mit dramatischen Folgen wie dem Verschwinden der Eisschilde, steigenden Meeresspiegeln und zunehmenden Wetterextremen. Erhöht sich die Temperatur höchstens um 1,5 °C, wären viele Auswirkungen des Klimawandels weniger gravierend. Dieses Ziel kann nach Einschätzung des Weltklimarats noch erreicht werden, wenn die Treibhausgasemissionen sehr schnell sinken (Abb. A) und der Atmosphäre große Mengen an Kohlenstoffdioxid (CO2) entzogen werden. Damit setzt der Weltklimarat bereits auf Methoden des Climate Engineering, um die Erderwärmung zu begrenzen. Und wenn alle Versuche, die Treibhausgasemissionen drastisch zu reduzieren scheitern sollten – könnte dann Climate Engineering der einzige Plan sein, um die Folgen des menschengemachten Klimawandels abzumildern?

Abb. A: Prognosen gehen davon aus, dass der weltweite Energiebedarf bis zum Jahr 2040 um 30% steigen wird. Gleichzeitig muss die Menschheit ihre Treibhausgas-Emissionen bis 2050 auf Null reduzieren, um das 1,5-Grad-Ziel zu erreichen.

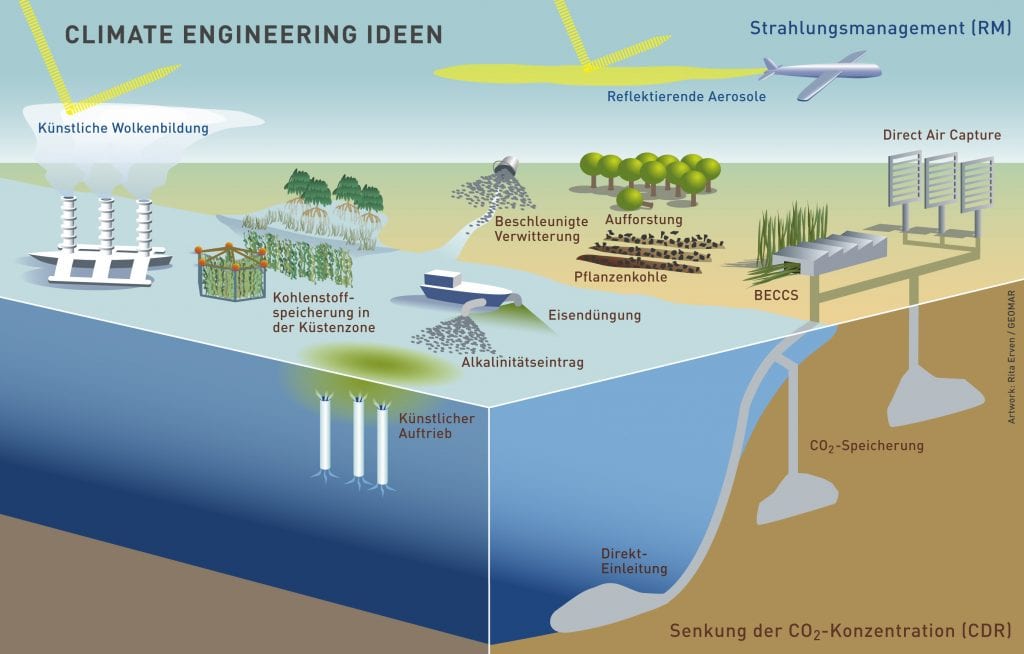

© M. Janson, statista.com

Die Temperatur der Erdatmosphäre wird durch drei Größen bestimmt: die einfallende kurzwellige Sonnenstrahlung, der Anteil dieser Strahlung, der sofort wieder reflektiert wird (z. B. durch Wolken, Partikel in der Atmosphäre oder Polareis) und drittens die Infrarot-Strahlung. Sie entsteht, wenn die Planetenoberfläche die Sonnenergie in Form langwelliger Wärmestrahlung wieder an die Atmosphäre abgibt. Diese lnfrarot-Strahlung bewirkt den Treibhauseffekt, da Treibhausgase einen Teil dieser Strahlung absorbieren und dann wieder in alle Richtungen abstrahlen. Der Anteil, der nach unten abgestrahlt wird, trägt zur Erwärmung der Erde bei. Zum Problem wird der Treibhauseffekt, wenn der Gehalt an absorbierenden Gasen in der Atmosphäre zu stark steigt und sich die globale Durchschnittstemperatur immer weiter erhöht. Mittlerweile gibt es eine Reihe von Vorschlägen, um mit Climate Engineering die menschengemachte Erderwärmung mit technischen Mitteln zu begrenzen (Abb. B). Sie verfolgen dabei zwei Wege: Mit einigen Methoden soll CO2 aus der Atmosphäre entfernt und langfristig an Land oder im Ozean gespeichert werden (Carbon Dioxide Removal, CDR). Andere Verfahren greifen dagegen in den Strahlungshaushalt der Erde ein. Sie sehen vor, Teile der wärmenden Sonnenstrahlung, die auf die Erde trifft, abzuschirmen (Radiation Management, RM). Zum jetzigen Zeitpunkt gibt es keine CDR- oder RM-Methode, die im ausreichend großen Maßstab eingesetzt werden könnte, um die Erderwärmung zu stoppen. Viele der vorgeschlagenen Ideen sind unter Wissenschaftlern und in der Öffentlichkeit umstritten. Es gibt wissenschaftliche, rechtliche, ethische oder politische Bedenken gegen Feldexperimente und gegen den Einsatz der Methoden. Und es sind noch jede Menge Fragen zum Climate Engineering offen: Wie gut funktionieren die unterschiedlichen Methoden tatsächlich? Wann wären sie einsatzbereit? Und vor allem: Welche Klimawirkungen und Umweltrisiken haben die Verfahren, wenn sie im großen Maßstab eingesetzt werden?

Abb. B: Begriffe und gängige Abkürzungen beim Climate Engineering (CE): Der Carbon Dioxid Removal Ansatz (CDR) entfernt CO2 aus der Atmosphäre mit Methoden wie Direct Air Capture oder schnell wachsende Pflanzen. Abgetrenntes CO2 wird gespeichert (Carbon Capture and Storage, CCS) oder weiterverwendet (Carbon Capture and Usage, CCU). Biomasse-Kraftwerke könnten frei werdendes CO2 sofort wieder speichern (Bioenergie-CCS, BECCS). Der zweite Ansatz, Radiation Management (RM), greift in den Strahlungshaushalt ein und verringert die Erwärmung durch künstliche Wolkenbildung oder reflektierende Aerosole (z. B. Sulfatpartikel).

© Artwork: R. Erven, GEOMAR / CC BY-NC-ND 4.0

Um die CO2-Konzentration zu reduzieren, könnten unter anderem Direct-Air-Capture-Systeme aufgestellt, schnell wachsende Pflanzen angebaut oder große Flächen aufgeforstet werden. Die Direct-Air-Capture-Systeme filtern CO2 mit Bindemitteln aus der Umgebungsluft und verflüssigen es anschließend. Das abgetrennte CO2 wird entweder weiterverwendet oder unterirdisch gespeichert. Allerdings müssten enorme Luftmengen gefiltert werden, da der CO2-Anteil in Luft nur 0,04 % beträgt. Dafür wären große Anlagen nötig, die viel Energie verbrauchen. Werden schnell wachsende Pflanzen angebaut, könnte die Energie bei deren Verbrennung in Biomasse-Kraftwerken genutzt und das frei werdende CO2 sofort gespeichert werden. Ein großes Problem beim Anbau von solchen „Energiepflanzen“ oder der großflächigen Aufforstung ist der Verbrauch von Flächen, Wasser und Dünger – Ressourcen, die für Nahrungspflanzen nicht mehr zur Verfügung stehen. Ein anderer Vorschlag sieht vor, Bioabfälle wie Pflanzenreste, Gülle oder Klärschlamm in eine Art Pflanzenkohle umzuwandeln. In Ackerböden eingearbeitet, verbessern die Materialien die Bodeneigenschaften und der enthaltene Kohlenstoff wird über lange Zeit gespeichert.

Fast ein Viertel der emittierten CO2-Menge löst sich natürlicherweise im Oberflächenwasser der Ozeane. Bei dem Vorgang entstehen u.a. Kohlensäure und Oxoniumionen, die den pH-Wert des Meerwassers von 8,2 (vorindustriell) auf derzeit 8,1 absenken. Dieser Versauerung des Ozeans wirken die natürlich vorkommenden Carbonationen im Meerwasser entgegen. Sie stammen aus dem Sediment am Meeresboden oder werden über Flüsse (Verwitterung von kalkhaltigen Gesteinen) eingetragen. Die Carbonationen können die Oxoniumionen binden. Bei der beschleunigten Verwitterung wird dieser Vorgang verstärkt: Silikat- oder Carbonat-Gesteinsmehle werden in Minen abgebaut und ins Oberflächenwasser des Ozeans geleitet. Durch die zugeführten Carbonationen kann der Ozean wieder vermehrt CO2 aus der Atmosphäre binden. Um einen globalen Effekt zu erreichen, bräuchte man enorme Mengen an Gestein und die Methode ist insgesamt kosten- und energieintensiv. Außerdem ist noch nicht untersucht, wie sich die Einleitung von Gesteinsmehlen im großen Maßstab auf das Meeresökosystem auswirkt. Manche der Gesteine bestehen auch aus eisenhaltigen Mineralsalzen, die im Meer als Dünger wirken können: das Plankton wächst schneller und betreibt mehr Fotosynthese, wodurch mehr CO2 in Biomasse umgewandelt wird. Dieser Effekt wird bei der künstlichen Eisendüngung ausgenutzt. Allerdings lagert sich nur ein kleiner Teil der Biomasse im Sediment am Meeresgrund ein, wo der Kohlenstoff dann für einige Jahrzehnte gespeichert wäre. Und um einen spürbaren Effekt zu erreichen, müsste der gesamte südliche Ozean permanent gedüngt werden. Aufgrund der negativen Effekte einer Überdüngung dürfte sich diese Methode nicht durchsetzen. Eine Variante der Eisendüngung ist der künstliche Auftrieb, bei dem mit Pumpen das mineralstoffreiche Tiefenwasser in höhere, lichtdurchflutete Bereiche befördert wird, um dort das Planktonwachstum anzuregen.

Die meisten Methoden des Strahlungsmanagements (RM) verändern den Einfall der kurzwelligen Sonnenstrahlung, indem sie die Reflexion erhöhen. Ob diese Methoden die Erderwärmung abschwächen, aufhalten oder gar rückgängig machen könnten und mit welchen Risiken sie verbunden sind, untersuchen Wissenschaftler wie Hauke Schmidt und Ulrike Niemeier vom Max-Planck-Institut für Meteorologie in Hamburg. Zusammen mit Forschenden aus vielen Ländern der Welt, u.a. Großbritannien, USA, China, Frankreich und Norwegen arbeiten sie daran, mögliche Auswirkungen von Climate Engineering besser zu verstehen. Um keine unnötigen Gefahren für Mensch und Natur heraufzubeschwören, führen die Forscher ihre Experimente nicht im Großlabor Erde durch, sondern gehen den möglichen Folgen des RM mit Supercomputern auf den Grund. „Wir wollen mit Hilfe von Computersimulationen die Unsicherheit reduzieren, die bezüglich der Wirksamkeit und der potenziellen Nebenwirkungen der vorgeschlagenen Methoden bestehen“, erklärt Schmidt.

Die Wissenschaftler haben sich drei Methoden aus dem Radiation Management herausgepickt, um sie auf ihre Tauglichkeit zu prüfen: Spiegel im Weltraum, künstliche Wolkenbildung und Injektion von Schwefeldioxid in die Stratosphäre. Bei der künstlichen Wolkenbildung wird Meerwasser in großen Mengen zerstäubt und in bestehende Wolken über den Ozeanen gesprüht. So entstehen nicht nur viel mehr, sondern auch viel kleinere Wassertröpfchen. Die Wolken werden heller und reflektieren das Sonnenlicht besser. Die Vision, Schwefeldioxid als Schutzschild gegen die Sonnenstrahlung zu nutzen, ist bereits über 30 Jahre alt und stammt von dem Klimawissenschaftler Michail Budyko. Im Jahr 2006 hat der Atmosphärenforscher und Chemie-Nobelpreisträger Paul Crutzen, der lange Zeit am Max-Planck-Institut für Chemie in Mainz geforscht hat, diese Idee erneut aufgegriffen und bekannt gemacht.

Inspiriert wurden Crutzen und seine Mitstreiter unter anderem durch ein Naturereignis, das sich im Jahr 1991 ereignete: den Ausbruch des Pinatubo-Vulkans auf der philippinischen Insel Luzon (siehe Geomax 23). Rund 17 Millionen Tonnen Schwefeldioxid wurden dabei hoch in die Atmosphäre geschleudert. Durch verschiedene chemische Reaktionen entstanden dabei in der Stratosphäre große Mengen an Sulfatpartikeln, die das Sonnenlicht teilweise reflektierten. In der Folge drang weniger Sonnenstrahlung durch die Erdatmosphäre zur Erdoberfläche und die bodennahen Luftschichten kühlten sich ab. In den zwei Jahren nach der Pinatubo-Eruption gab es nach Berechnungen von Klimaforschern einen globalen Temperaturabfall von bis zu 0,4 °C. Crutzen schlug vor, die Möglichkeit, die Stratosphäre mit Millionen Tonnen Schwefelwasserstoff oder Schwefeldioxid zu impfen, genauer zu untersuchen. Die Gase könnten mithilfe von Ballonen oder als Zusatz zum Flugzeugtreibstoff in die Stratosphäre gebracht werden. Da die Sulfatpartikel mit der Zeit in die Troposphäre absinken, müssten diese Maßnahmen allerdings regelmäßig wiederholt werden. Viele Billionen US-Dollar jährlich könnte der Sulfat-Schleier Schätzungen zufolge kosten.

Um die Effekte der RM-Maßnahmen zu erforschen, kommen unterschiedliche Klimamodelle zum Einsatz. Im internationalen Projekt GeoMIP wurden verschiedene Szenarien, die auf verschiedenen Entwicklungen der zukünftigen Treibhausgasemissionen basieren, berechnet. Eines davon geht beispielsweise von einem ungebremsten Anstieg der Emissionen aus – und damit von einer Vervierfachung der CO2-Konzentration in der Atmosphäre im Vergleich zum vorindustriellen Niveau. Die Wissenschaftler vergleichen die Ergebnisse ihrer Simulationen und suchen nach „robusten“ Resultaten. Gemeint sind damit Wirkungen und Folgen des jeweiligen Ansatzes, die in allen Modellen auftauchen und deshalb als weitgehend gesichert gelten können.

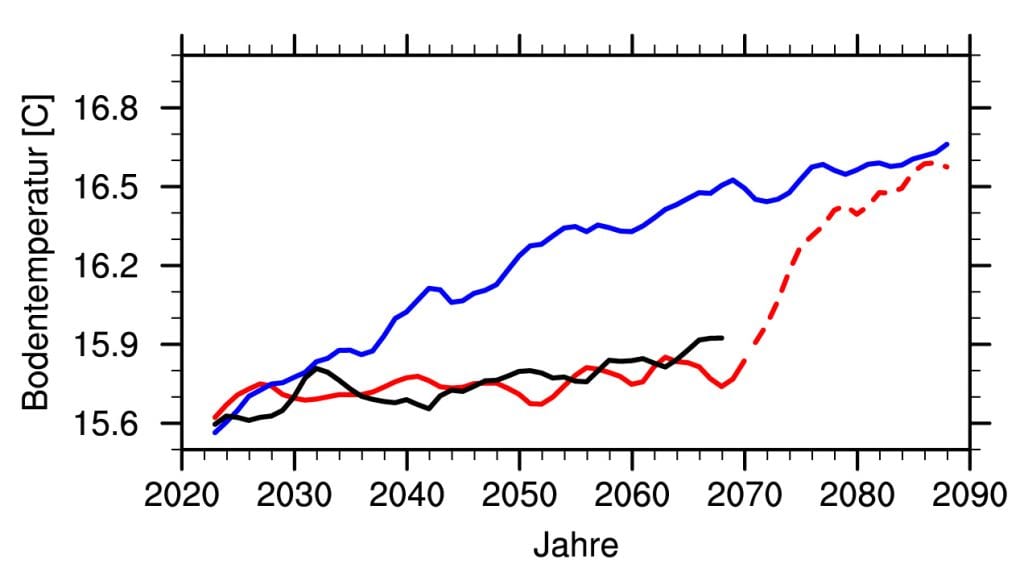

Abb. C: Global gemittelte Bodentemperatur von drei Simulationen. Blau: Klimaszenario mit der Annahme eines mittelstarken Anstiegs der Treibhausgase (RCP 4.5), Schwarz: Szenario mit den Werten der Treibhausgase des Jahres 2020, Rot: Klimaszenario mit den Ausgangsbedingungen des „blauen“ Klimaszenarios und Injektionen von Schwefeldioxid. Die Erderwärmung wird vermindert und die Klimabedingungen des Jahres 2020 bleiben erhalten. Wird die Injektion im Jahr 2050 abgebrochen, steigt die globale Bodentemperatur in weniger als 10 Jahren um 0,5 °C

© U. Niemeier, MPI für Meteorologie / CC BY-NC-SA 4.0

Mittlerweile haben die Forschenden viele Modellrechnungen vorgenommen und es liegen auch Ergebnisse zu Sulfat-Aerosolen in der Stratosphäre vor. „Da der Vorschlag, Schwefeldioxid in die Stratosphäre einzutragen, dem natürlichen Beispiel großer Vulkaneruptionen folgt, kann man bei dieser Methode wohl am ehesten davon ausgehen, dass sie tatsächlich einen Abkühlungseffekt hat“, sagt Hauke Schmidt. Den Modellen zufolge wird die abkühlende Wirkung umso größer, je mehr Schwefeldioxid man in einem solchen Experiment in die Stratosphäre einbringt. Eine Verdoppelung der Dosis führt allerdings nicht zu einem doppelt so großen Effekt, sondern nur zu einer moderaten Steigerung der Abkühlung, so die Resultate. Das liegt daran, dass bei stärkerem Impfen die Sulfatpartikel mit der Zeit verklumpen, schwerer werden und aus der Stratosphäre absinken. Die Simulationen der Wissenschaftler zeigen, dass man mit Schwefeldioxid-Injektionen im großen Maßstab das Temperaturniveau von 2020 halten könnte (Abb. C). Doch in der Umsetzung dürfte das schwierig werden. „Wenn wir bis zum Jahr 2100 trotz steigender CO2-Emissionen das Klima von 2020 allein mithilfe von Schwefeldioxid halten wollten, dann müsste die Menschheit jährlich fünf bis achtmal so viel Schwefeldioxid in die Stratosphäre bringen, wie 1991 beim Ausbruch des Pinatubo frei wurden“, erklärt Ulrike Niemeier.

Die Simulationen liefern jedoch nicht nur Hinweise zur Effektivität der RM-Verfahren, sie decken auch die Nebenwirkungen auf: Sollte es wirklich gelingen, die Temperatur auf ein vorindustrielles Niveau zu bringen, würde der Niederschlag zwischen drei und sechs Prozent abnehmen. Besonders ausgeprägt wäre dieser Trend über dicht besiedelten Landmassen, Europa und Nordamerika eingeschlossen. „Das heißt, wir würden tatsächlich ein ganz neues Klima erzeugen“, sagt Schmidt. Wie sich dieses auf die Landwirtschaft und die Nahrungsmittelversorgung der wachsenden Weltbevölkerung auswirken würde, ist noch unklar. Und die Modellrechnungen zeigen auch, dass durch Schwefeldioxid-Injektionen im großen Maßstab Luftströme in den Tropen zusammenbrechen würden. „Welche Konsequenzen das für das Weltklima hat, können wir noch gar nicht absehen. Klar aber ist, dass es durch das Schwefeldioxid zu großräumigen Änderungen der Luftströmungen kommen wird“, sagt Niemeier. Außerdem ist bis jetzt zu wenig darüber bekannt, wie sich die Abschattung durch den Sulfat-Schleier auf den globalen Wasserkreislauf oder das Pflanzen-wachstum auswirkt. Oder ob die Aerosole den Ozonabbau in der Stratosphäre verstärken. „Inzwischen ist uns aber auch klar, dass die Nebenwirkungen von RM-Methoden klein sind, verglichen mit den Bedingungen bei einem ungebremsten Klimawandel. Mit RM sind die Temperaturen erträglicher und Wetterextreme seltener und weniger heftig“, gibt die Wissenschaftlerin zu bedenken.

Dürfen solche Verfahren wie das Ausbringen von Sulfat-Aerosolen eingesetzt werden? Wer entscheidet über ihre Nutzung? Wer bestimmt die Temperatur auf der Erde? Müssen alle Staaten der Erde zustimmen oder kann es auch Alleingänge einzelner Länder geben? Wer bezahlt die Maßnahmen und wer haftet für möglicherweise gravierende (Umwelt-) Folgen? Wissenschaftler wie Hauke Schmidt und Ulrike Niemeier sehen ihre Aufgabe darin, die Vor- und Nachteile von Methoden des Climate Engineering zu beschreiben. Die naturwissenschaftlichen Erkenntnisse helfen Gesellschaft und Politikern, zusammen mit ethischen, sozialen und rechtlichen Argumenten über den Einsatz von CE-Verfahren zu diskutieren. Bislang gibt es keine international verbindlichen Regeln, welche Methoden des Climate Engineering zulässig sind. Das muss auf Grundlage des jeweiligen Völkervertrags- und Völkergewohnheitsrecht entschieden werden. Rechtswissenschaftler haben bei den Verfahren zur CO2-Entnahme generell weniger rechtliche Bedenken als bei den RM-Methoden. Dabei gilt für alle Staaten der Präventionsgrundsatz: wer CE-Verfahren einsetzt, muss Absprachen mit anderen Ländern treffen oder die Umweltverträglichkeit prüfen lassen. Aus Sicht der Ethik spricht u. a. gegen die Weiterentwicklung der CE-Methoden, dass dadurch die Risiken der Treibhausgas-Emissionen zunehmend ignoriert werden könnten, weil „Plan B“ greift. Für die Weiterentwicklung spricht die Tatsache, dass die Folgen des Klimawandels vor allem unsere Nachkommen treffen werden. Im Sinne einer Verantwortung für die nächsten Generationen sollten die CE-Methoden wenn nötig einsatzbereit sein. Mögliche negative Auswirkungen von CE-Verfahren auf Artenvielfalt, Ozonschicht, Wasserreserven oder Ernährungssicherheit zeigen weitere Wertekonflikte auf.

Noch ist offen, ob Climate Engineering jemals im großen Maßstab eingesetzt werden wird. Letztlich hängt dies vom Potenzial und den Risiken der einzelnen Methoden ab, sowie dem Aufwand, sie umzusetzen. Sicher ist, dass je nach Region und Zustand des Klimas verschiedene Methoden zum Einsatz kommen müssten. Einig sind sich die meisten Klimaforscher auch in einem weiteren Punkt: Das Klimasystem ist extrem komplex und es lässt sich kaum vorhersagen, wie es im Detail auf das Climate Engineering reagieren würde. Daher ist es unabdingbar und der bessere Plan, die Treibhausgas-Emissionen drastisch zu reduzieren und damit die Ursache der Erderwärmung zu bekämpfen.

Abbildungshinweise:

Titelbild: © Imago Photo / Adobe Stock

Abb. A: © M. Janson, statista.com

Abb. B: © Artwork: R. Erven, GEOMAR / CC BY-NC-ND 4.0

Abb. C: © U. Niemeier, MPI für Meteorologie / CC BY-NC-SA 4.0

Der Text wird unter CC BY-NC-SA 4.0 veröffentlicht.

GEOMAX Ausgabe 18, aktualisiert 11/2020; Text: D. Lohmann, T. Fendt; Redaktion: T. Fendt

Diese Ausgabe wird nicht mehr aktualisiert und steht nur noch als PDF-Datei im Archiv zur Verfügung.

Diese Ausgabe wird nicht mehr aktualisiert und steht nur noch als PDF-Datei im Archiv zur Verfügung.